¿Y si los chips de IA dejaran de ser tan caros?

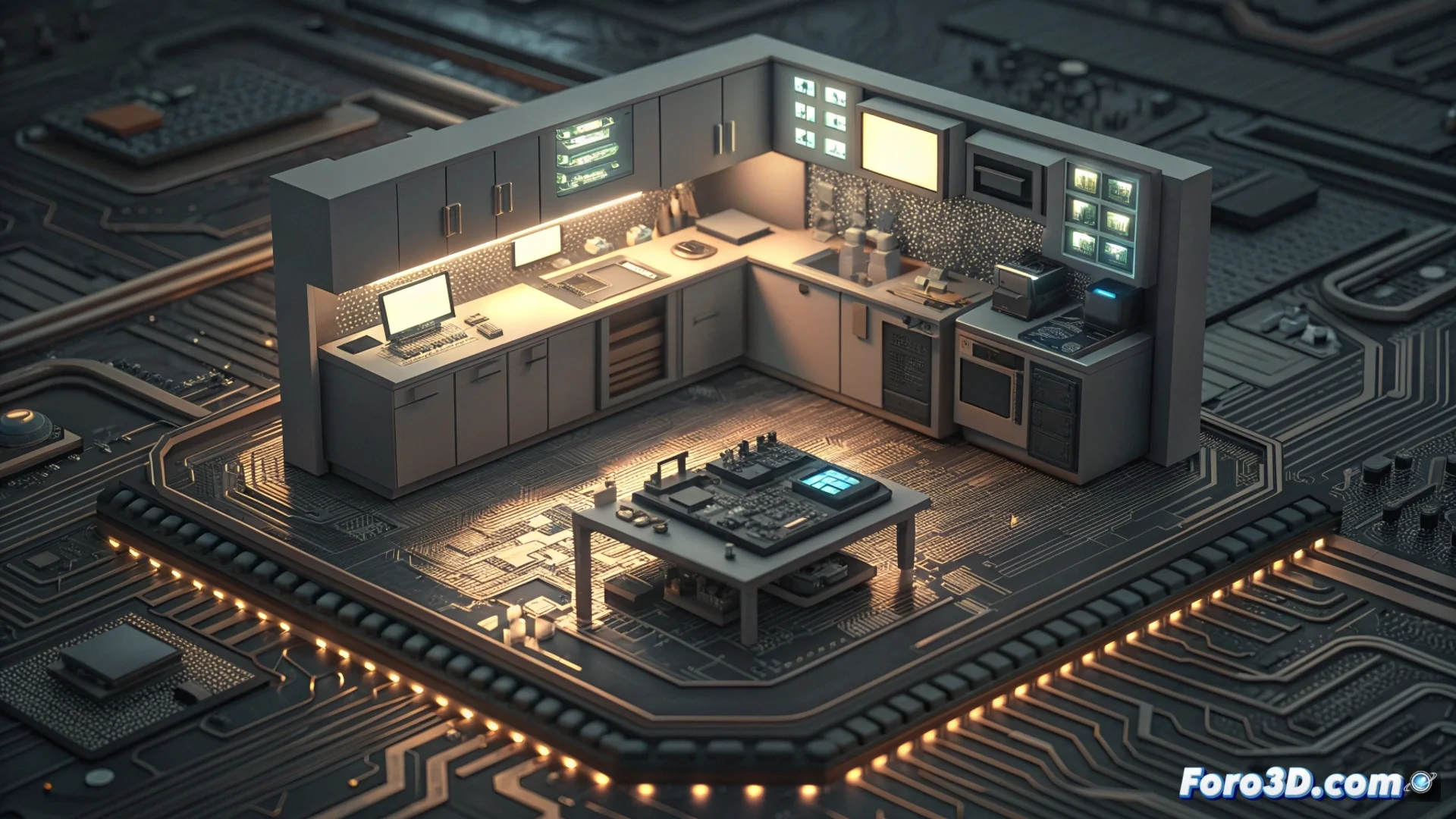

Imagina que entrenar a una inteligencia artificial fuera como intentar hacer una cena gourmet en una cocina diminuta. Necesitas espacio, ¿verdad? Pues a los chips actuales les pasa algo parecido: usan una memoria superrápida pero cara y escasa, llamada HBM. Positron AI, una startup que acaba de convertirse en unicornio, propone una idea radical: ¿y si usamos mucha más memoria normal, como la de tu móvil, pero a lo bestia?

La apuesta: cambiar el Ferrari por una flota de camiones

En lugar de depender de esa memoria HBM de lujo, su nuevo acelerador, bautizado Asimov, apostará por montones de memoria LPDDR5x, la prima más eficiente de la RAM de los teléfonos. La clave está en la cantidad: podrían meter varios terabytes, una barbaridad. Piensa en ello como cambiar un Ferrari (rápido, pero con maletero pequeño) por una flota de camiones de reparto. Puede que cada uno no sea el más veloz, pero juntos mueven una cantidad de datos enorme de forma más barata y consumiendo menos energía.

Algo curioso que probablemente no sabías

Lo más alucinante es el calendario. Han recaudado 230 millones con esta promesa, pero el chip Asimov no estará listo para pruebas hasta finales del primer trimestre de 2027. Es como financiar la construcción de un nuevo tipo de avión años antes de que vuele. Muestra la fe (y el dinero) que hay detrás de esta idea de reinventar la infraestructura de los centros de datos para que la IA no dependa de componentes tradicionales tan limitados.

Si tienen éxito, podríamos ver una democratización de la IA de alto nivel. Algo así como pasar de tener supercomputadoras solo para gigantes tecnológicos a poder alquilar potencia de forma más asequible. Quién sabe, tal vez en el futuro tu asistente de IA favorita corra, en parte, gracias a una idea que nació de usar la memoria del móvil, pero a escala titánica.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Citar

Citar