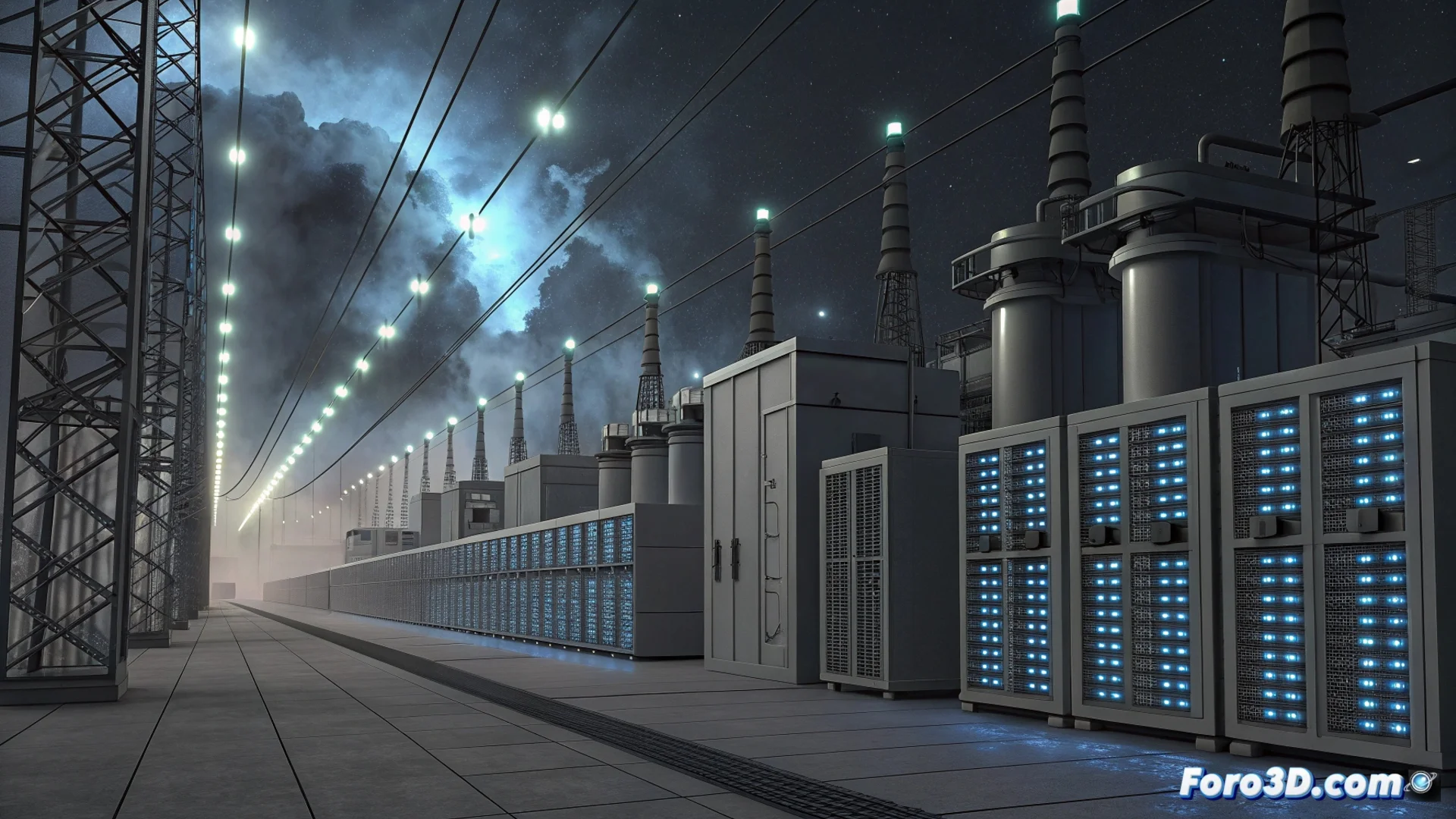

La demanda de energía de los centros de datos con IA crece alarmantemente

La construcción de centros de datos especializados en inteligencia artificial no muestra señales de detenerse. Esta expansión constante genera una presión creciente sobre las redes eléctricas, especialmente en Estados Unidos. Un informe reciente de BloombergNEF proyecta que la demanda de energía de estos centros podría escalar hasta alcanzar los 106 gigavatios para el año 2035. Esta cifra representa un aumento significativo respecto a la capacidad actual y subraya la intensidad energética que requiere entrenar y ejecutar modelos de IA avanzados.

El informe de BloombergNEF cuantifica el impacto energético

El análisis de BloombergNEF, publicado en diciembre, ofrece una de las estimaciones más concretas sobre el futuro consumo. Los 106 gigavatios proyectados equivalen a suministrar energía a decenas de millones de hogares. Este crecimiento exponencial está directamente vinculado a la carrera por desarrollar infraestructura para modelos de lenguaje grande y otras aplicaciones de IA que necesitan procesar cantidades masivas de datos. La necesidad de enfriar los servidores de alto rendimiento agrava aún más este consumo.

La industria busca equilibrar innovación y sostenibilidad

Este escenario obliga a la industria tecnológica y a los reguladores a buscar soluciones. Se exploran activamente estrategias para mejorar la eficiencia de los chips, usar sistemas de refrigeración más avanzados e integrar fuentes de energía renovable. El objetivo es sostener el ritmo de innovación en IA sin colapsar la red eléctrica. Algunas empresas ya planean construir centros de datos cerca de parques solares o eólicos para garantizar un suministro más verde.

Mientras algunos se preocupan por el impacto ambiental, otros ya imaginan un futuro donde la IA optimice el consumo energético de... la propia IA, creando un bucle recursivo que solo un centro de datos podría resolver.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Citar

Citar