vamos por partes:

3D_Cubano, empiezas preguntando por equipos de gama alta: DualXeon y i7 980x, y estamos ahora hablando de i7 920 y AMD?

Que es lo que quieres, un equipo top de gama y gastarte una buena pasta, o un equipo de gama media con precio ajustado?

No es lo mismo comparar el i7 980x con un dual Xeon que con un 930/920 o AMD.

Para mí, en equipos de rendimiento, AMD no existe. Al menos hasta qué lancen su próxima arquitectura y volveremos a darle una oportunidad.

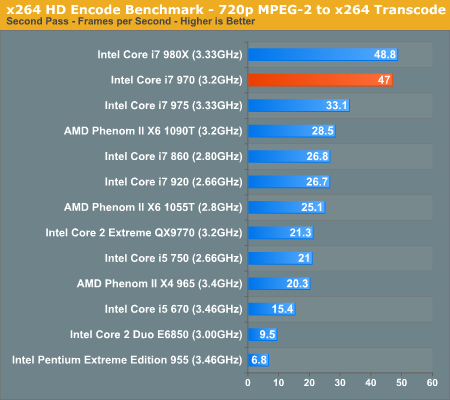

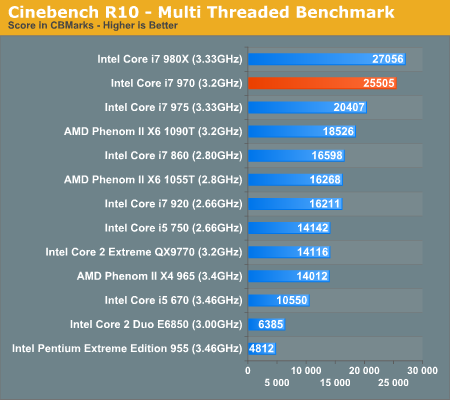

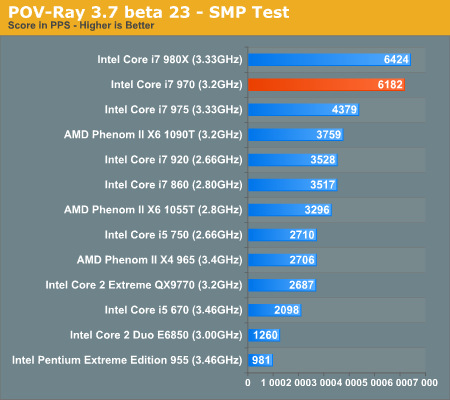

Respecto al dual Xeon, el i7 980x posiblemente sea menos caro, con un rendimiento superior, sí, he dicho superior, 6 Cores a 3,3 GHz rinden más que 8 Cores a 2,4ghz. Y además el i7 980x permite OC sin forzar placa ni memoria. Es la virtud de los micros Extreme Edition.

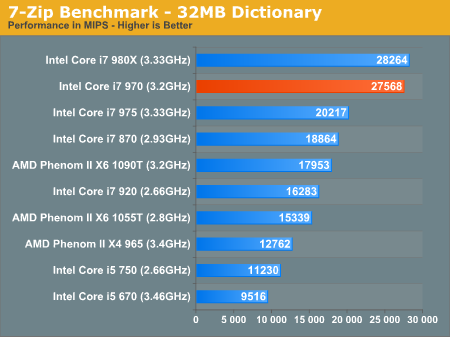

Si lo comparamos con el 920/930, simeplemente no hay color. Cierto, el i7 980x es bastante más caro. 1000 euros vs 250EUR, pero la diferencia de rendimiento es también muy grande. 3,3 GHz vs 2,6ghz, que además el i7 980x lo puedes subir a 4ghz sin despeinarse y sin forzar el equipo, pero es que, además el i7 980x es 6CORES y el 920/930 solo 4CORES.

En resumen, el i7 980x es más del doble de rápido que el 920/930 renderizando y trabajando.

Para mí estaría claro, si hay presupuesto, el i7 980x. Y la diferencia de precio la rentabilizas en poco tiempo.

Del tema placas, el usb3 y el sata3 son los nuevos estándares, pero no hay que tirar cohetes.

Si el equipo lo quieres para granja de render, no necesitas nada de eso. Con un simple disco duro barato sata2 vas sobrado.

Si el equipo lo quieres para trabajo, y vas a montar un SD, pues incluso con el sata2 vas bien, la controladora permite 300mb/s y un SD de los buenos tiene transferencias de 150-250 mb/s.

Si vas a montar un raid de discos SD, entonces es cuando necesitas el sata3, pero realmente vas a montar esa burrada? Pues está claro que no lo necesitas.

El usb3, está muy reciente. Así que tardarán en aparecer periféricos que lo aprovechen, y si estas pensando en discos duros externos: e-sata y que me quiten todo lo demás.

Además, siempre podrás en un futuro añadir una tarjeta

PCI Express sata3 o usb3.

Del tema garantías, todas las marcas dan más o menos la misma garantía. 2 años. Es lo que exige la ley.

Juan A, estas mosca con Asus por que se te jodió una gráfica en 6 meses? Estaba en garantía, cuál es el problema? Eso es cuestión de suerte, pero además estoy seguro que se joden más gráficas de marcas baratas como club3d que de Asus o gigabyte.

Sin duda si comparamos Asus o gigabyte con supermicro o tyan, no hay color, pero porque son marcas de sectores diferentes. Asus y gigabyte, son marcas de consumo, y tienen buena calidad en comparación con otras marcas del mismo sector. Y también hay que tener en cuenta el modelo, que no es lo mismo una Asus de gama baja de 80 euros que una pedazo de Asus de 300EUR.

Respecto a la ram, trabajo a diario con escenas que necesitan más de 4 gigas de RAM, y los equipos van como la seda con Windowsxp-64 y Windows7-64, en

3dsmax(64) y

Vray(64) o Mental Ray(64).

Si lanzas un render que necesita más Ram de la que tienes, pues se ralentiza por el disco duro, pero no se cierra. Si

Blender se cierra, muy mal por esa aplicación, pensaba qué estaba más madura.

Aun así, estoy por ver si eso es cierto, porque me suena a qué estas trabajando en 32bits.

Citar

Citar