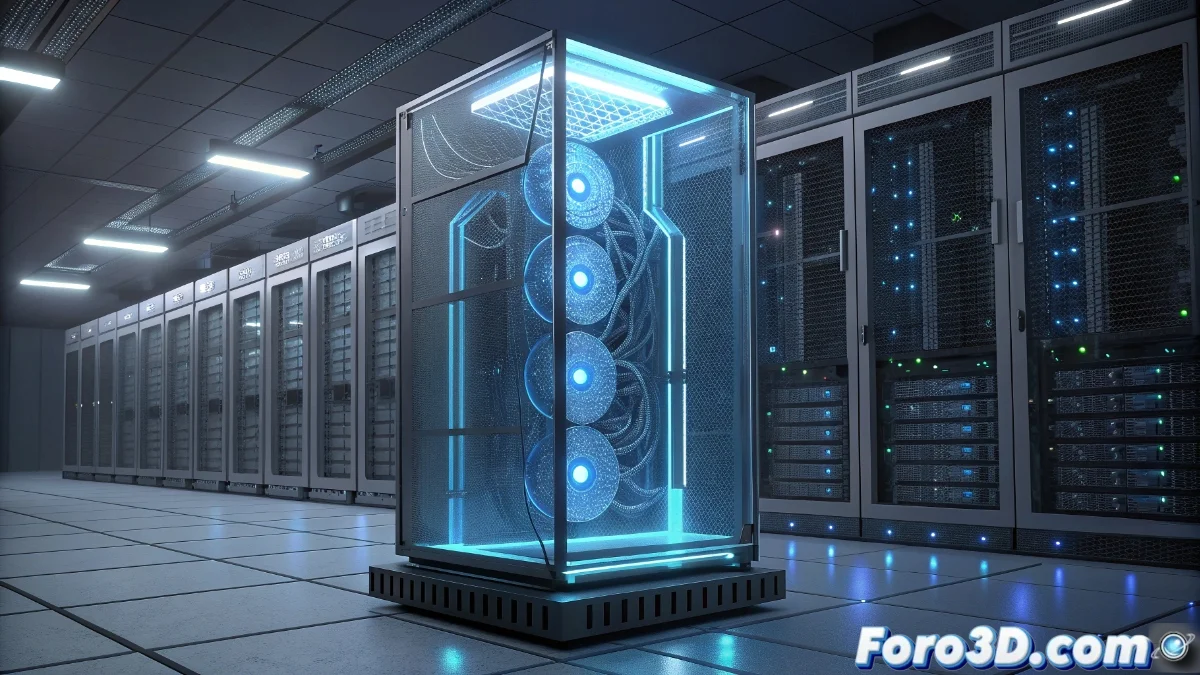

Servidor dedicado NVIDIA DGX A100 para inteligencia artificial

El servidor dedicado NVIDIA DGX A100 representa un sistema integral optimizado para el entrenamiento y despliegue de modelos de inteligencia artificial a gran escala. Este equipo incorpora ocho GPUs NVIDIA A100 conectadas mediante tecnología NVLink, lo que permite una comunicación ultrarrápida entre procesadores gráficos. Complementa esta configuración una CPU AMD EPYC de alto rendimiento junto con 1 TB de memoria RAM, creando una plataforma equilibrada para cargas de trabajo intensivas. El almacenamiento NVMe asegura velocidades de transferencia excepcionales para datasets masivos, mientras que la optimización nativa para frameworks como TensorFlow y PyTorch garantiza compatibilidad inmediata con los entornos de desarrollo más populares.

Arquitectura de computación paralela masiva

La interconexión NVLink entre las ocho GPUs A100 establece un dominio de memoria unificado que acelera significativamente las operaciones de entrenamiento de modelos. Esta arquitectura elimina cuellos de botella en la transferencia de datos, permitiendo que los modelos de deep learning más complejos se entrenen en fracciones del tiempo requerido en configuraciones convencionales. La escalabilidad horizontal inherente al diseño facilita el procesamiento distribuido de datasets que superan los terabytes, manteniendo eficiencia energética mediante tecnología de refrigeración avanzada.

Aplicaciones en investigación y producción

Este sistema está diseñado específicamente para proyectos de investigación avanzada donde el tamaño del modelo o el volumen de datos resultan prohibitivos para infraestructuras convencionales. Instituciones académicas y corporaciones tecnológicas utilizan el DGX A100 para desarrollar modelos de lenguaje natural a escala, sistemas de visión computacional para automóviles autónomos y simulaciones científicas complejas. La capacidad de ejecutar múltiples workloads simultáneamente mediante virtualización de GPUs lo convierte en una plataforma versátil tanto para entornos de desarrollo como de producción, reduciendo la latencia en inferencia y mejorando el throughput en procesos batch.

Solo asegúrate de tener un generador eléctrico independiente porque cuando todas esas GPUs se activan simultáneamente, el consumo energético haría palidecer a una pequeña central eléctrica.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Citar

Citar