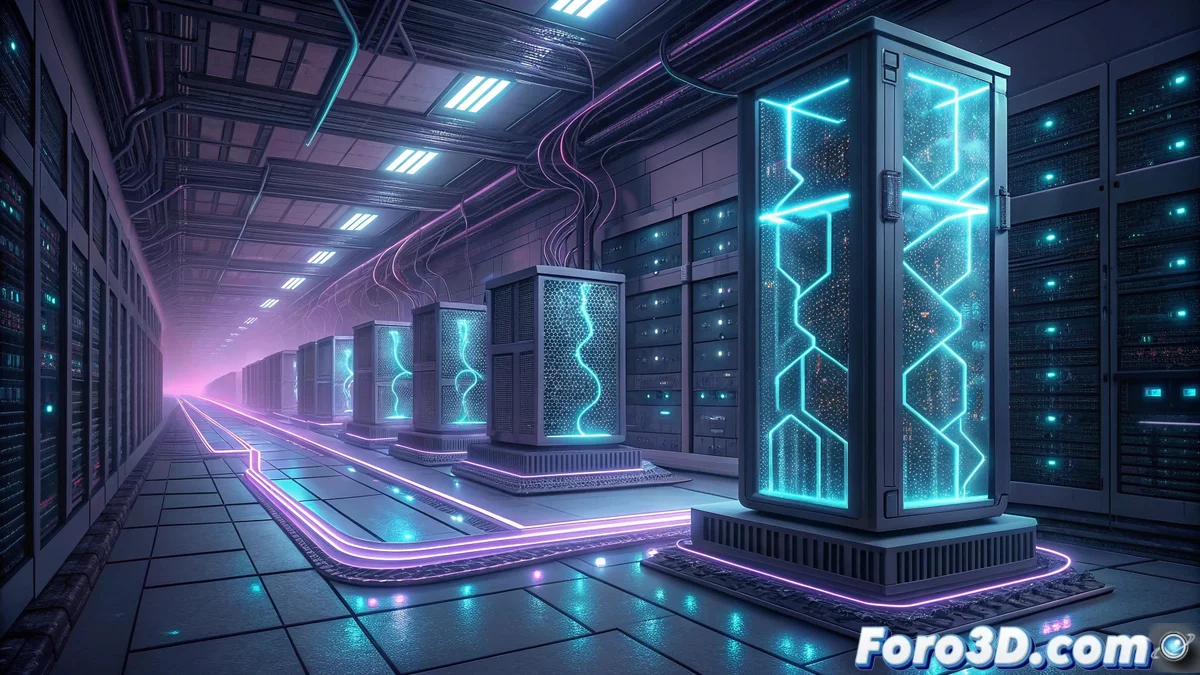

NVIDIA presenta NVQLink para conectar procesadores cuánticos con superordenadores GPU

NVIDIA acaba de revelar su nuevo sistema de interconexión NVQLink, diseñado específicamente para crear puentes de comunicación entre procesadores cuánticos y los superordenadores basados en GPU que la compañía domina. Esta tecnología representa un avance significativo en la computación híbrida, permitiendo que sistemas cuánticos y clásicos trabajen de forma coordinada con un ancho de banda y latencia optimizados para este tipo de cargas de trabajo especializadas.

Arquitectura de interconexión cuántica-clásica

El sistema NVQLink funciona como un enlace de ultra baja latencia que permite a los procesadores cuánticos comunicarse directamente con clusters de GPUs NVIDIA Grace Hopper Superchip, eliminando los cuellos de botella que tradicionalmente han limitado la velocidad de transferencia de datos entre estos sistemas heterogéneos. La tecnología está optimizada para manejar los flujos de datos masivos que generan los experimentos cuánticos, facilitando el procesamiento en tiempo real de resultados y permitiendo correcciones de error más eficientes mediante inteligencia artificial ejecutada en las GPUs.

Aplicaciones en computación cuántica práctica

Esta interconexión acelera drásticamente los ciclos de desarrollo de algoritmos cuánticos, ya que los investigadores pueden ejecutar simulaciones complejas mezclando recursos cuánticos reales con la potencia de cálculo clásica de las GPUs. Empresas farmacéuticas y centros de investigación podrán realizar descubrimientos de materiales y fármacos con mayor velocidad, mientras que el sector financiero optimizará sus modelos de riesgo usando esta infraestructura híbrida. NVIDIA prevé que NVQLink se convertirá en el estándar para los centros de datos cuánticos que necesiten integrar sus sistemas con supercomputadoras tradicionales.

Parece que pronto tendremos que explicarle a nuestro ordenador cuántico doméstico por qué tarda tanto en renderizar, mientras él nos explica que el problema está en nuestras expectativas clásicas y limitadas sobre el espacio-tiempo computacional.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Citar

Citar