Quando i modelli multimodali perdono la visione ma mantengono il linguaggio

La ottimizzazione di modelli multimodali per guadagnare velocità ed efficienza rivela una curiosa asimmetria: le loro capacità di elaborazione visiva si deteriorano molto più rapidamente rispetto alle abilità di ragionamento linguistico. Questa disparità rappresenta un ostacolo critico per sistemi che dipendono da una interpretazione visiva precisa, dagli assistenti intelligenti alle automazioni robotiche domestiche. 👁️🗨️

Il problema fondamentale della compressione multimodale

Quando gli sviluppatori riducono le dimensioni dei modelli multimodali per migliorare le loro prestazioni, la comprensione visiva subisce un impatto sproporzionato rispetto all'elaborazione del linguaggio. Questo degrado può condurre a interpretazioni errate di scene e oggetti, anche quando il componente linguistico conserva una certa capacità di analisi. La conseguenza pratica è che sistemi apparentemente funzionali possono commettere errori gravi in compiti che richiedono percezione visiva precisa.

Conseguenze dell'asimmetria visivo-linguistica:- Assistenti virtuali che interpretano male fotografie e scene visive

- Robot domestici con difficoltà a riconoscere oggetti e contesti

- Sistemi di automazione che falliscono in ambienti visivamente complessi

"La percezione visiva deteriorata in modelli più piccoli può portare a interpretazioni errate anche quando il componente linguistico mantiene capacità di ragionamento"

Extract+Think: La soluzione in due fasi

La ricerca presenta Extract+Think, una metodologia che opera mediante due fasi ben definite. Prima, addestra il modello per estrarre consistentemente dettagli visivi rilevanti in base a ogni istruzione specifica. Successivamente, il sistema applica ragionamento passo a passo su quegli elementi visivi identificati per generare risposte precise. Questo approccio strutturato garantisce che anche i modelli compatti mantengano un alto livello di comprensione visiva focalizzandosi su aspetti critici prima dell'analisi.

Vantaggi dell'approccio Extract+Think:- Estrazione selettiva di dettagli visivi rilevanti

- Ragionamento strutturato su elementi identificati

- Preservazione delle capacità visive in modelli ottimizzati

Applicazioni pratiche in ambienti con risorse limitate

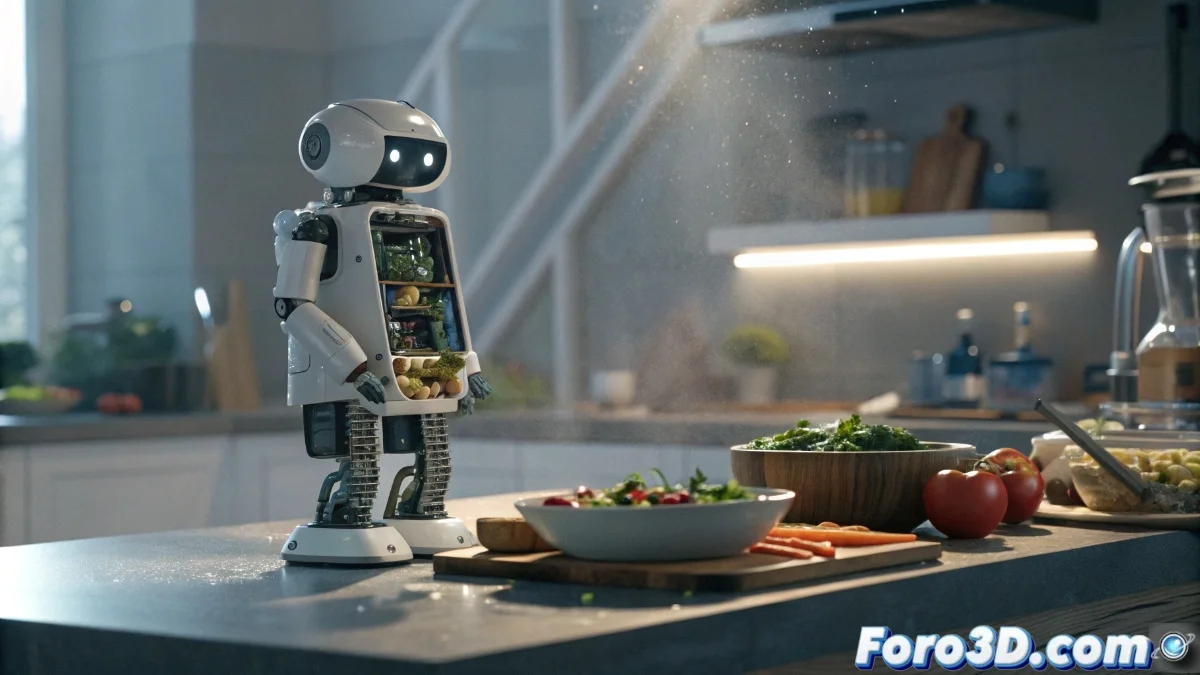

I benefici di questa metodologia risultano particolarmente preziosi in scenari del mondo reale dove l'hardware ha capacità limitate. Un assistente virtuale che analizza immagini può mantenere una comprensione corretta delle scene se prima identifica oggetti e dettagli importanti prima di ragionare su di essi. Similmente, un robot domestico con risorse computazionali limitate può riconoscere ingredienti in una cucina e seguire ricette con precisione, focalizzandosi su elementi visivi chiave mediante questo processo di estrazione e ragionamento sequenziale.

Casi d'uso con hardware limitato:- Assistenti virtuali mobili che analizzano fotografie dell'ambiente

- Robot domestici economici che interagiscono con oggetti quotidiani

- Sistemi embedded che elaborano informazioni visive in tempo reale

La paradosso dell'apprendimento umano vs artificiale

Risulta ironico che le intelligence artificiali debbano imparare a separare l'essenziale dall'accessorio prima di formulare conclusioni, un'abilità che gli umani sviluppiamo naturalmente durante la prima infanzia. Mentre i bambini acquisiscono questa capacità all'asilo, le macchine richiedono anni di addestramento specializzato per raggiungere un livello simile di discernimento visivo selettivo. Questa paradosso sottolinea la complessità fondamentale di replicare la percezione umana in sistemi artificiali. 🤖