Cuando los modelos multimodales pierden visión pero mantienen lenguaje

Cuando los modelos multimodales pierden visión pero mantienen lenguaje

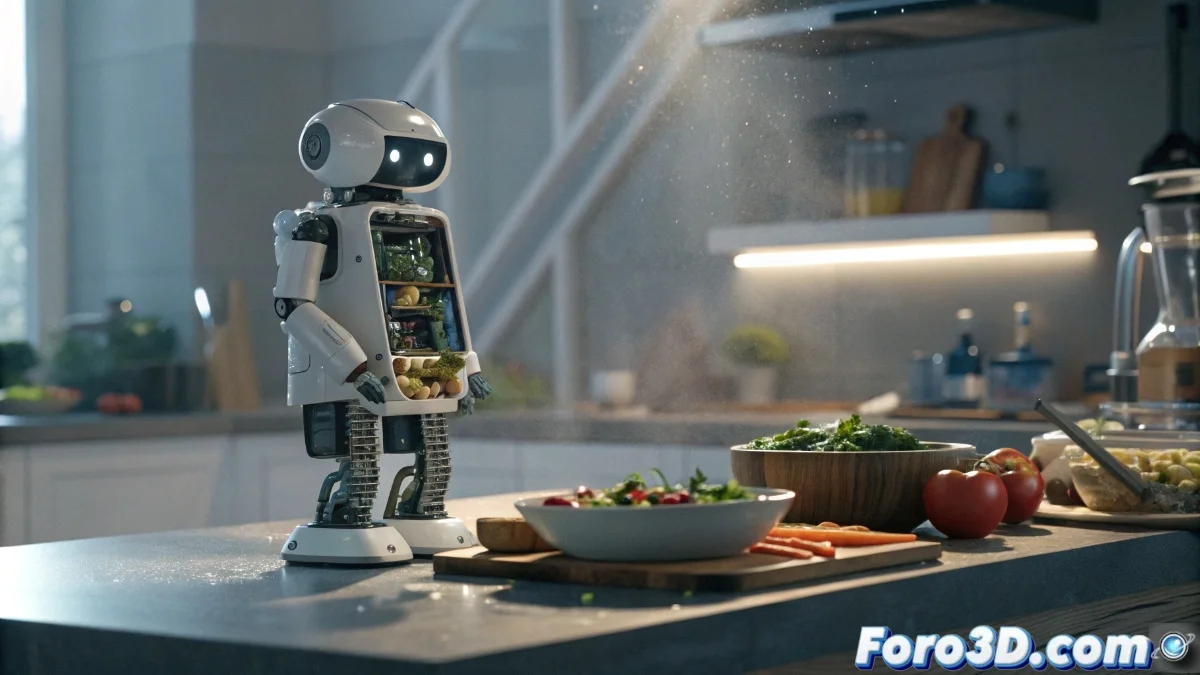

La optimización de modelos multimodales para ganar velocidad y eficiencia revela una curiosa asimetría: sus capacidades de procesamiento visual se deterioran mucho más rápido que sus habilidades de razonamiento lingüístico. Esta disparidad representa un obstáculo crítico para sistemas que dependen de una interpretación visual precisa, desde asistentes inteligentes hasta automatizaciones robóticas domésticas. 👁️🗨️

El problema fundamental de la compresión multimodal

Cuando los desarrolladores reducen el tamaño de los modelos multimodales para mejorar su rendimiento, la comprensión visual sufre un impacto desproporcionado comparado con el procesamiento de lenguaje. Esta degradación puede conducir a interpretaciones erróneas de escenas y objetos, incluso cuando el componente lingüístico conserva cierta capacidad de análisis. La consecuencia práctica es que sistemas aparentemente funcionales pueden cometer errores graves en tareas que requieren percepción visual precisa.

Consecuencias de la asimetría visual-lingüística:- Asistentes virtuales que malinterpretan fotografías y escenas visuales

- Robots domésticos con dificultades para reconocer objetos y contextos

- Sistemas de automatización que fallan en entornos visualmente complejos

"La percepción visual deteriorada en modelos más pequeños puede llevar a interpretaciones erróneas incluso cuando el componente lingüístico mantiene capacidad de razonamiento"

Extract+Think: La solución en dos etapas

La investigación presenta Extract+Think, una metodología que opera mediante dos fases bien definidas. Primero, entrena al modelo para extraer consistentemente detalles visuales relevantes según cada instrucción específica. Posteriormente, el sistema aplica razonamiento paso a paso sobre esos elementos visuales identificados para generar respuestas precisas. Este enfoque estructurado garantiza que incluso modelos compactos mantengan un alto nivel de comprensión visual al focalizarse en aspectos críticos antes del análisis.

Ventajas del enfoque Extract+Think:- Extracción selectiva de detalles visuales relevantes

- Razonamiento estructurado sobre elementos identificados

- Preservación de capacidades visuales en modelos optimizados

Aplicaciones prácticas en entornos con recursos limitados

Los beneficios de esta metodología resultan particularmente valiosos en escenarios del mundo real donde el hardware tiene capacidades restringidas. Un asistente virtual que analiza imágenes puede mantener una comprensión correcta de las escenas si primero identifica objetos y detalles importantes antes de razonar sobre ellos. Similarmente, un robot doméstico con recursos computacionales limitados puede reconocer ingredientes en una cocina y seguir recetas con precisión, enfocándose en elementos visuales clave mediante este proceso de extracción y razonamiento secuencial.

Casos de uso con hardware limitado:- Asistentes virtuales móviles que analizan fotografías del entorno

- Robots domésticos económicos que interactúan con objetos cotidianos

- Sistemas embebidos que procesan información visual en tiempo real

La paradoja del aprendizaje humano vs artificial

Resulta irónico que las inteligencias artificiales necesiten aprender a separar lo esencial de lo accesorio antes de formular conclusiones, una habilidad que los humanos desarrollamos naturalmente durante la primera infancia. Mientras que los niños adquieren esta capacidad en kindergarten, las máquinas requieren años de entrenamiento especializado para alcanzar un nivel similar de discernimiento visual selectivo. Esta paradoja subraya la complejidad fundamental de replicar la percepción humana en sistemas artificiales. 🤖