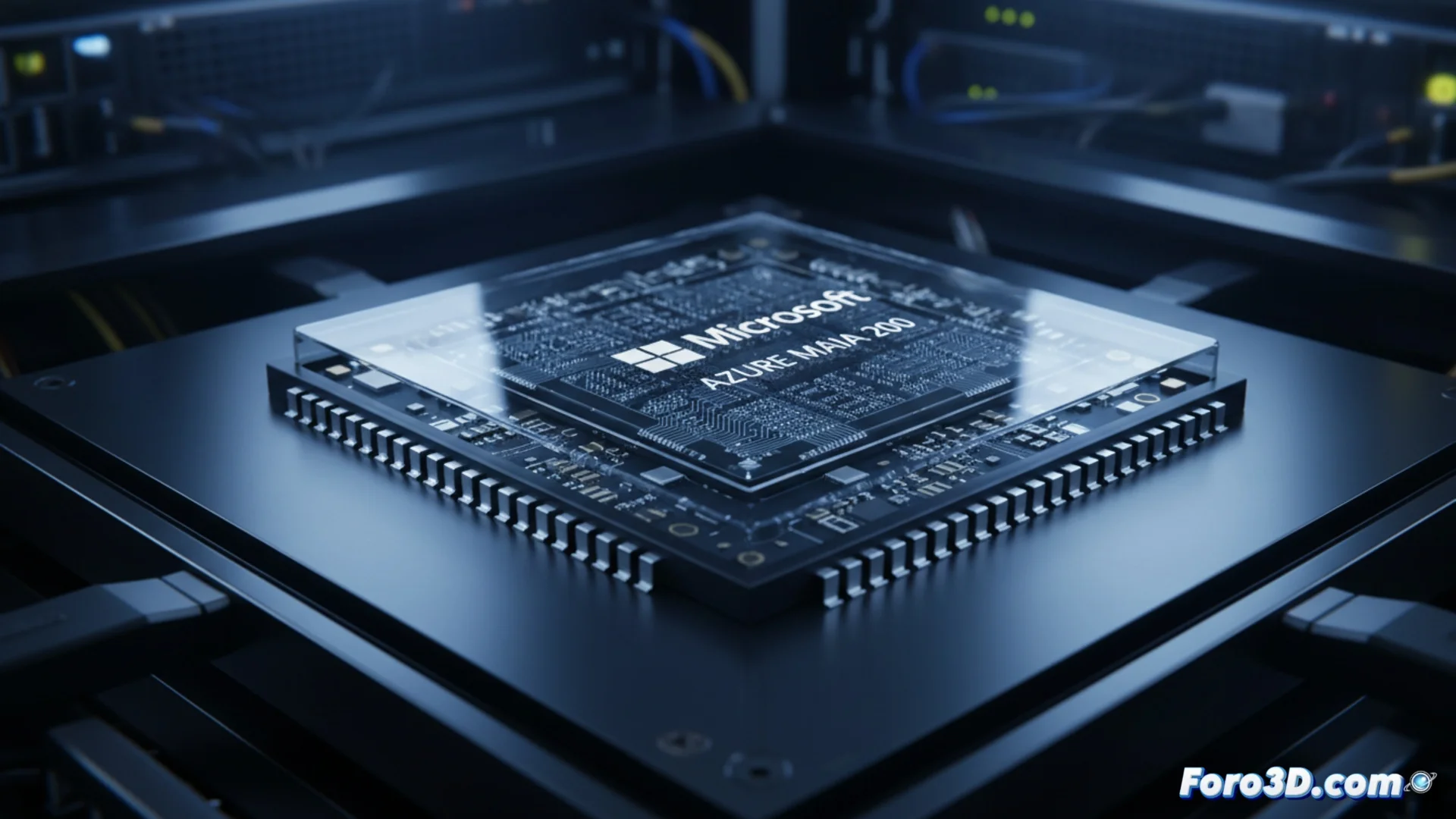

Microsoft lancia l'acceleratore IA Azure Maia 200

L'azienda tecnologica Microsoft ha presentato il suo nuovo acceleratore di intelligenza artificiale, l'Azure Maia 200. Questo componente rappresenta l'evoluzione nella famiglia di processori Maia, creati specificamente per funzionare in server. Il suo compito principale è far funzionare modelli di IA già addestrati, affinché generino risposte e previsioni. Microsoft progetta questo hardware per gestire queste operazioni con grande velocità e un livello di efficacia che, secondo l'azienda, supera quanto offrono attualmente i rivali come Amazon e Google in questo campo. 🚀

Focus su efficacia e velocità per l'inferenza

L'Azure Maia 200 è fabbricato con lo scopo di ottimizzare l'esecuzione di modelli di IA su larga scala all'interno della piattaforma cloud Azure. Producendo il proprio chip, Microsoft cerca di avere un controllo più diretto sull'intera catena di hardware e software, il che può permettere di regolare con maggiore precisione come il sistema gestisce i dati. Questo approccio cerca di ridurre i tempi di attesa e migliorare l'uso dell'energia nell'esecuzione di modelli complessi, dai grandi modelli linguistici ai sistemi che analizzano immagini. L'azienda non mostra tutti i dettagli della sua architettura, ma indica che il design dà priorità alla capacità della memoria e al modo in cui i chip si connettono tra loro per gestire gli enormi set di parametri dei modelli attuali.

Caratteristiche chiave dell'Azure Maia 200:- Progettato per eseguire compiti di inferenza IA con alta velocità.

- Cerca di migliorare l'efficienza energetica nei data center.

- Architettura che dà priorità alla larghezza di banda della memoria e all'interconnessione.

Sembra che la nuova competizione globale non si combatta con missili, ma con transistor e chi può processare una query sui gattini più velocemente.

Il panorama competitivo del silicio per IA

Il lancio del Maia 200 mostra una tendenza ampia nel settore tecnologico, dove i grandi fornitori di servizi cloud sviluppano i propri chip specializzati. Amazon ha i suoi processori Inferentia e Trainium, mentre Google opera con le sue Tensor Processing Units (TPU). Presentando il Maia 200, Microsoft consolida il suo piano di offrire un'infrastruttura IA distinta, competendo non solo nei servizi software ma anche nelle prestazioni dell'hardware sottostante. L'azienda prevede di implementare questi acceleratori nei suoi data center in tutto il mondo per potenziare servizi come Azure OpenAI Service e altre operazioni di IA generativa.

Principali attori nei chip personalizzati per il cloud:- Microsoft: Azure Maia 200 per inferenza.

- Amazon Web Services: Chip Inferentia e Trainium.

- Google Cloud: Tensor Processing Units (TPU).

Implicazioni per il futuro del cloud computing

Questa mossa sottolinea come la corsa alla supremazia in IA dipenda ora criticamente dal silicio personalizzato. Controllando sia il software che l'hardware, Microsoft intende offrire uno stack più integrato ed efficiente per i suoi clienti. L'obiettivo finale è processare modelli di intelligenza artificiale più grandi e complessi in modo più rapido e con minori costi operativi, definendo i nuovi standard di prestazioni nel cloud. 🔌