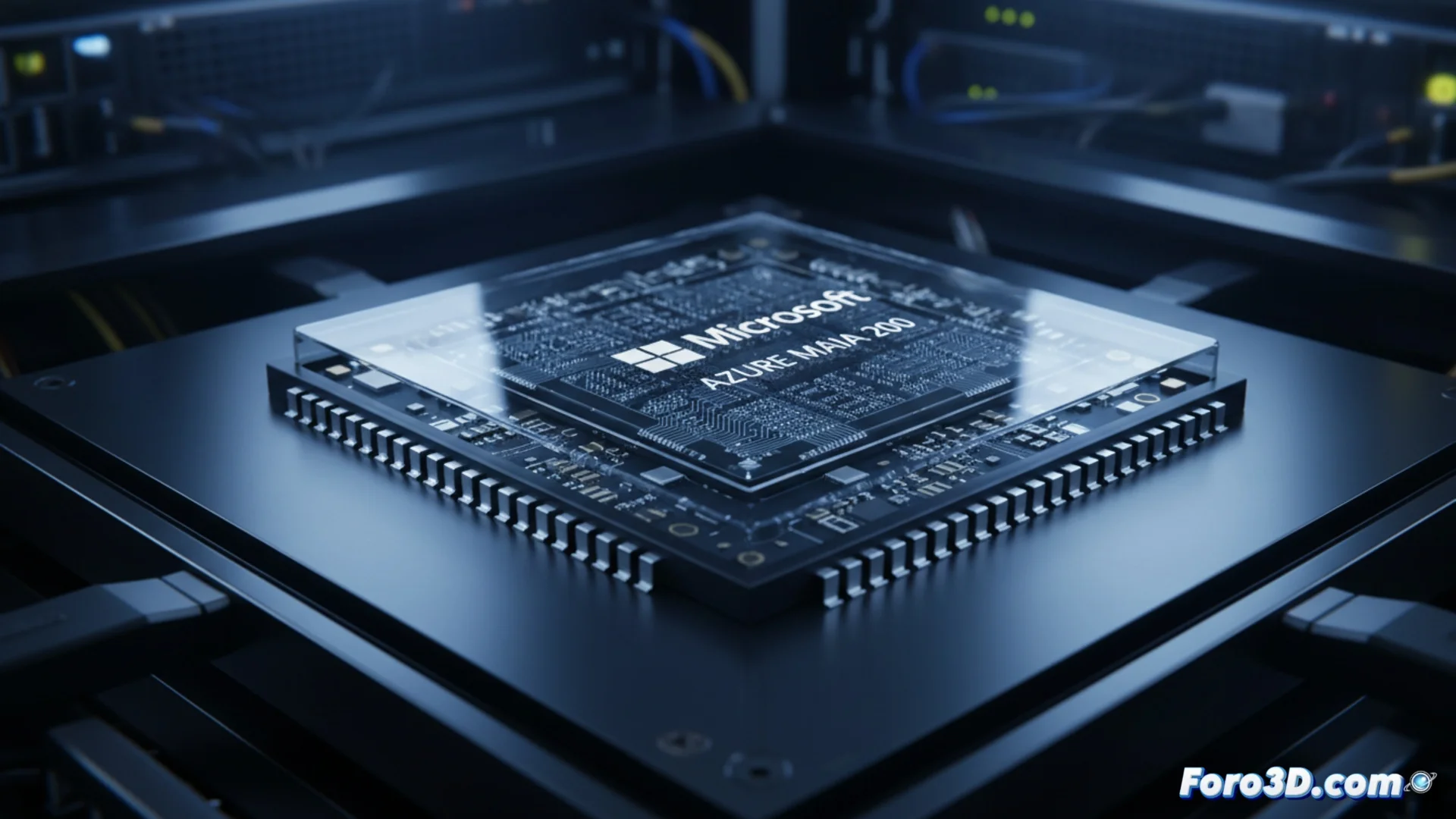

Microsoft lanza el acelerador de IA Azure Maia 200

Microsoft lanza el acelerador de IA Azure Maia 200

La empresa tecnológica Microsoft ha dado a conocer su nuevo acelerador de inteligencia artificial, el Azure Maia 200. Este componente representa la evolución en la familia de procesadores Maia, creados de forma específica para funcionar en servidores. Su tarea principal es hacer funcionar modelos de IA que ya están entrenados, para que generen respuestas y predicciones. Microsoft diseña este hardware para manejar estas operaciones con gran velocidad y un nivel de eficacia que, según la compañía, supera lo que ofrecen actualmente rivales como Amazon y Google en este campo. 🚀

Enfoque en eficacia y velocidad para inferencia

El Azure Maia 200 se fabrica con el propósito de optimizar cómo se ejecutan modelos de IA a gran escala dentro de la plataforma en la nube Azure. Al producir su propio chip, Microsoft busca tener un control más directo sobre toda la cadena de hardware y software, lo que puede permitir ajustar con más precisión cómo el sistema maneja los datos. Este método intenta reducir los tiempos de espera y mejorar cómo se usa la energía al correr modelos complejos, desde grandes modelos de lenguaje hasta sistemas que analizan imágenes. La firma no muestra todos los detalles de su arquitectura, pero indica que el diseño prioriza la capacidad de la memoria y cómo se conectan los chips entre sí para gestionar los enormes conjuntos de parámetros de los modelos actuales.

Características clave del Azure Maia 200:- Diseñado para ejecutar tareas de inferencia de IA con alta velocidad.

- Busca mejorar la eficiencia energética en centros de datos.

- Arquitectura que prioriza el ancho de banda de memoria y la interconexión.

Parece que la nueva competición global no se libra con misiles, sino con transistores y ver quién puede procesar una consulta sobre gatitos más rápido.

El panorama competitivo del silicio para IA

El lanzamiento del Maia 200 muestra una tendencia amplia en el sector tecnológico, donde los grandes proveedores de servicios en la nube desarrollan sus propios chips especializados. Amazon cuenta con sus procesadores Inferentia y Trainium, mientras que Google opera con sus Tensor Processing Units (TPU). Al presentar el Maia 200, Microsoft consolida su plan de ofrecer una infraestructura de IA distinta, compitiendo no solo en servicios de software sino también en el rendimiento del hardware que hay debajo. La compañía planea implementar estos aceleradores en sus centros de datos en todo el mundo para impulsar servicios como Azure OpenAI Service y otras operaciones de IA generativa.

Principales actores en chips personalizados para la nube:- Microsoft: Azure Maia 200 para inferencia.

- Amazon Web Services: Chips Inferentia y Trainium.

- Google Cloud: Tensor Processing Units (TPU).

Implicaciones para el futuro de la computación en la nube

Esta movida subraya cómo la carrera por la supremacía en IA ahora depende críticamente del silicio personalizado. Al controlar tanto el software como el hardware, Microsoft pretende ofrecer un stack más integrado y eficiente para sus clientes. El objetivo final es procesar modelos de inteligencia artificial más grandes y complejos de manera más rápida y con un menor coste operativo, definiendo los nuevos estándares de rendimiento en la nube. 🔌