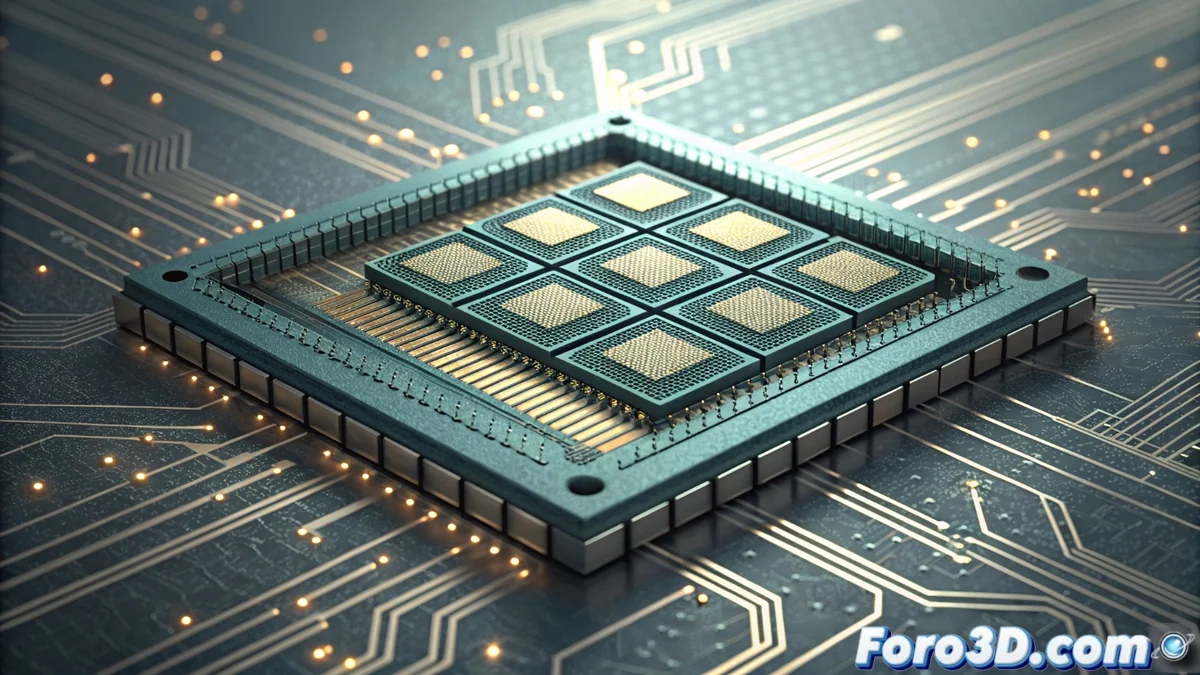

L'architettura PIM: elaborazione in memoria come rivoluzione dell'hardware

Il design dell'hardware sta vivendo una trasformazione radicale con l'emergere dell'architettura PIM (Processing In Memory). Questo paradigma sfida decenni di convenzioni posizionando la logica di calcolo direttamente all'interno dei moduli di memoria, siano essi DDR o le avanzate pile HBM (High Bandwidth Memory). Il principio è eseguire le operazioni dove risiedono i dati, eliminando la necessità di spostare informazioni massive attraverso il bus del sistema verso CPU o GPU. Questo cambiamento promette di risolvere il collo di bottiglia più critico della computazione moderna. 🚀

Vantaggi trasformativi e casi d'uso

L'impatto di PIM si manifesta in due dimensioni chiave: prestazioni brute ed efficienza energetica. Riducendo drasticamente il movimento dei dati, si consuma una frazione dell'energia, un avanzamento cruciale per i data center e la supercomputazione. Le applicazioni che gestiscono grandi insiemi di dati sono le principali beneficiarie. Qui, la latenza crolla e la banda passante effettiva si moltiplica.

Aree di applicazione chiave:- Apprendimento automatico e IA: Accelera l'addestramento dei modelli e l'inferenza elaborando matrici di dati direttamente in memoria.

- Analisi di database: Accelera query complesse e operazioni di filtraggio e ordinamento su grandi volumi di informazioni.

- Simulazione scientifica e rendering: Ottimizza compiti che richiedono accesso intensivo a buffer e geometrie complesse, comune in grafica 3D e CFD.

L'ironia finale è che, dopo decenni ottimizzando le CPU per spostare i dati più velocemente, la soluzione sembra essere non spostarli affatto.

Ostacoli sulla strada dell'adozione

Malgrado il suo potenziale, l'implementazione di PIM non è priva di sfide profonde. Richiede una reinvenzione completa delle gerarchie di memoria e del software che le gestisce. Gli sviluppatori necessitano di nuovi modelli di programmazione e strumenti per sfruttare questo elaborazione decentralizzata.

Sfide principali da superare:- Complessità di design: Integrare logica di computazione in chip di memoria densi pone problemi di fabbricazione, dissipazione del calore e affidabilità.

- Ecosistema software: Sono necessari compilatori, librerie e framework nuovi che astraggano la complessità dell'hardware per i programmatori.

- Architettura del sistema: Il coordinamento tra CPU, GPU e le multiple unità PIM in memoria richiede nuovi design di interconnessione e coerenza.

Il futuro e le implementazioni attuali

L'industria sta già avanzando con prototipi e prime soluzioni, segnalando una strada irreversibile. Aziende come Samsung con le sue memorie HBM-PIM, e giganti come AMD e Intel con architetture che esplorano concetti affini, stanno guidando questa ibridazione tra memoria ed elaborazione. Questo giro concettuale, che probabilmente Von Neumann non anticipò, ridefinisce i fondamenti della computazione, priorizzando la prossimità dei dati sulla velocità del loro trasporto. Il futuro dell'hardware sarà, senza dubbio, più integrato ed efficiente. 💡