La arquitectura PIM: procesamiento en memoria como revolución del hardware

La arquitectura PIM: procesamiento en memoria como revolución del hardware

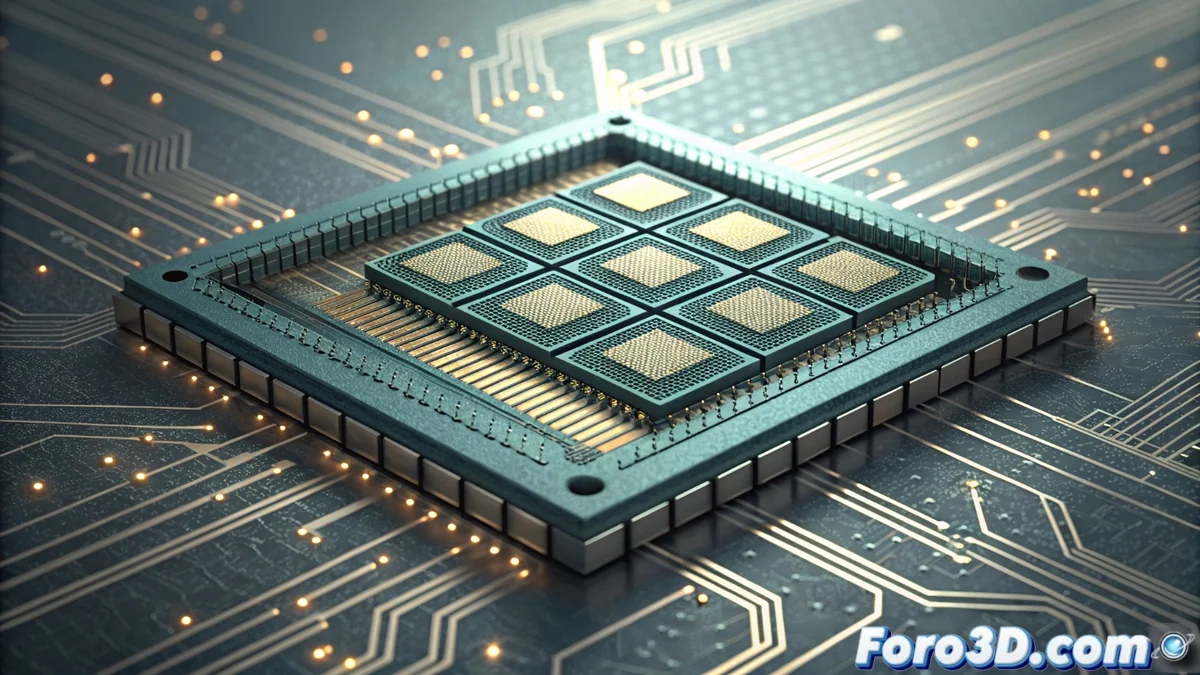

El diseño de hardware está experimentando una transformación radical con el surgimiento de la arquitectura PIM (Procesamiento en Memoria). Este paradigma desafía décadas de convención al colocar la lógica de cálculo directamente dentro de los módulos de memoria, ya sean DDR o las avanzadas pilas HBM (High Bandwidth Memory). El principio es ejecutar operaciones donde los datos residen, eliminando la necesidad de mover información masiva a través del bus del sistema hacia la CPU o GPU. Este cambio promete resolver el cuello de botella más crítico de la computación moderna. 🚀

Ventajas transformadoras y casos de uso

El impacto de PIM se manifiesta en dos dimensiones clave: rendimiento bruto y eficiencia energética. Al reducir drásticamente el movimiento de datos, se consume una fracción de la energía, un avance crucial para centros de datos y supercomputación. Las aplicaciones que manejan grandes conjuntos de datos son las principales beneficiarias. Aquí, la latencia se desploma y el ancho de banda efectivo se multiplica.

Áreas de aplicación clave:- Aprendizaje automático e IA: Acelera el entrenamiento de modelos y la inferencia al procesar matrices de datos directamente en la memoria.

- Análisis de bases de datos: Acelera consultas complejas y operaciones de filtrado y clasificación en grandes volúmenes de información.

- Simulación científica y renderizado: Optimiza tareas que requieren acceso intensivo a buffers y geometrías complejas, común en gráficos 3D y CFD.

La ironía final es que, tras décadas optimizando CPUs para mover datos más rápido, la solución parece ser no moverlos en absoluto.

Obstáculos en el camino de la adopción

A pesar de su potencial, la implementación de PIM no está libre de desafíos profundos. Requiere una reinvención completa de las jerarquías de memoria y del software que las gestiona. Los desarrolladores necesitan nuevos modelos de programación y herramientas para aprovechar este procesamiento descentralizado.

Retos principales a superar:- Complejidad de diseño: Integrar lógica de computación en chips de memoria densos plantea problemas de fabricación, disipación de calor y fiabilidad.

- Ecosistema de software: Se necesitan compiladores, librerías y frameworks nuevos que abstraigan la complejidad del hardware para los programadores.

- Arquitectura del sistema: La coordinación entre la CPU, GPU y las múltiples unidades PIM en memoria requiere nuevos diseños de interconexión y coherencia.

El futuro y las implementaciones actuales

La industria ya está avanzando con prototipos y primeras soluciones, señalando un camino irreversible. Empresas como Samsung con sus memorias HBM-PIM, y gigantes como AMD e Intel con arquitecturas que exploran conceptos afines, están liderando esta hibridación entre memoria y procesamiento. Este giro conceptual, que probablemente Von Neumann no anticipó, redefine los fundamentos de la computación, priorizando la proximidad de los datos sobre la velocidad de su transporte. El futuro del hardware será, sin duda, más integrado y eficiente. 💡