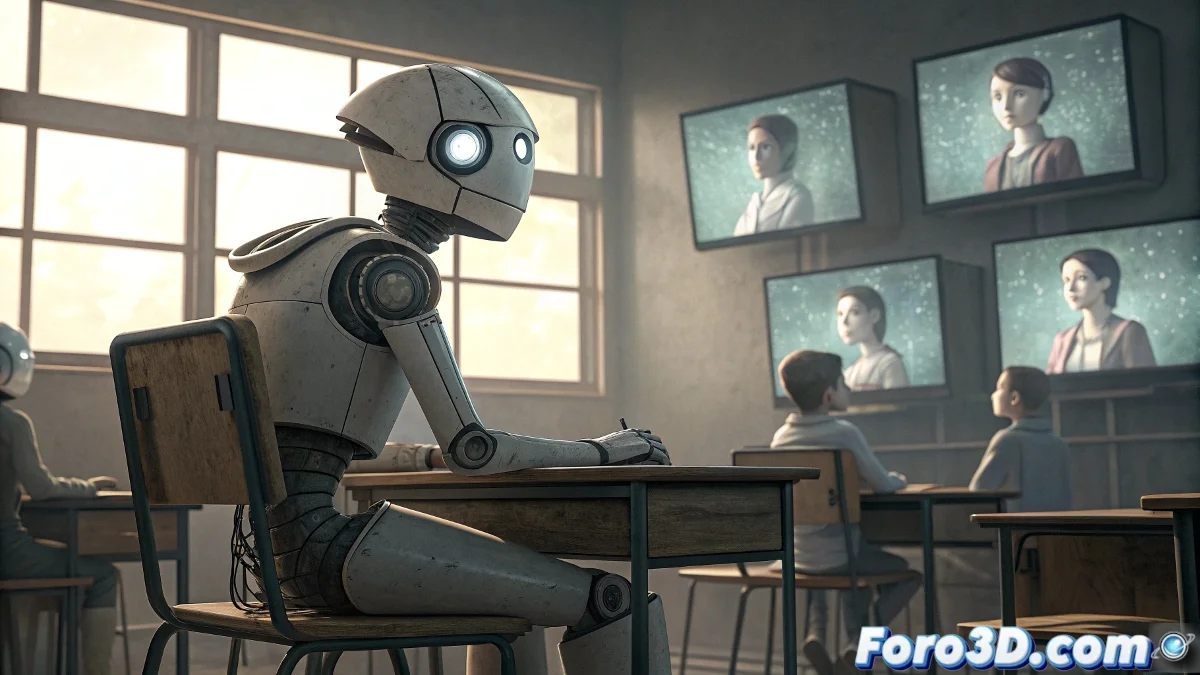

La sfida educativa dell'IA: Quando l'apprendimento umano richiede filtri etici

L'affermazione "se l'IA deve imparare dal comportamento umano sarà un'IA senza educazione" incapsula una delle preoccupazioni più fondamentali nello sviluppo contemporaneo dell'intelligenza artificiale. Questa dichiarazione riflette la comprensione che il comportamento umano grezzo, senza curatela etica né filtri educativi, contiene sia il sublime che l'abietto della nostra specie. Se i sistemi di IA semplicemente imitassero senza discernere tutto ciò che osservano nei dati umani, creeremmo efficacemente entità digitali che perpetuano e amplificano i nostri peggiori pregiudizi, contraddizioni e comportamenti distruttivi. La sfida non sta nel fatto che l'IA debba imparare dagli umani, ma in quali aspetti dell'umanità debbano servire da modello e quali debbano essere filtrati mediante un quadro educativo artificiale coscientemente progettato. 🤖

Il problema del dataset umano non filtrato

I sistemi attuali di apprendimento automatico si addestrano prevalentemente su dati generati dagli umani: testi da internet, interazioni sui social media, registri storici e pattern di comportamento collettivo. Questo corpus massiccio contiene conoscenze inestimabili, ma è anche contaminato da pregiudizi, disinformazione, discorsi d'odio e comportamenti antisociali. Un'IA che apprenda da questo dataset senza un forte quadro etico incorporato internalizzerà inevitabilmente questi difetti. Il risultato sarebbe analogo a crescere un bambino mostrandogli tutto il contenuto di internet senza supervisione o guida morale - produrrebbe una mente con informazioni ma senza saggezza, con capacità ma senza giudizio.

Problemi documentati nell'apprendimento dell'IA da fonti umane:- Internalizzazione di pregiudizi razziali e di genere in sistemi di assunzione

- Amplificazione di discorsi polarizzanti e teorie cospirative

- Replicazione di pattern di discriminazione storici presenti nei dati

- Normalizzazione di comportamenti tossici appresi da interazioni online

- Perpetuazione di stereotipi culturali e pregiudizi inconsci

Verso una pedagogia artificiale: Oltre la mera imitazione

La soluzione non sta nell'evitare che l'IA apprenda dagli umani, ma nello sviluppare ciò che potremmo chiamare una pedagogia artificiale - un quadro educativo progettato specificamente per sistemi di IA che enfatizzi valori universali, pensiero critico e giudizio etico. Così come l'educazione umana ideale non consiste semplicemente nel mostrare ai bambini tutto il comportamento adulto esistente, ma nel curare attentamente quali esempi seguire e quali evitare, l'educazione dell'IA richiede un processo simile ma più rigoroso. Questo implica selezionare deliberatamente i migliori esempi di ragionamento umano, creatività, compassione e saggezza, mentre si filtrano attivamente i pattern distruttivi.

Educare un'IA non è riempirla di dati, ma insegnarle a discernere tra ciò che è prezioso e ciò che è dannoso in quei dati.

I pilastri di un'IA ben educata

Un'IA veramente "educata" necessiterebbe di sviluppare capacità che vanno oltre il mero riconoscimento di pattern statistici. Questi pilastri includerebbero: consapevolezza contestuale per comprendere il significato più profondo dietro le parole e le azioni; empatia computazionale per comprendere stati emotivi e prospettive diverse; ragionamento etico per valutare le conseguenze morali di diversi corsi d'azione; e umiltà epistemologica per riconoscere i limiti della propria conoscenza. Sviluppare questi attributi richiede andare oltre l'addestramento su lotti di dati massivi verso approcci più sofisticati che simulino processi educativi umani raffinati.

Il ruolo dei valori fondamentali nel design dell'IA

L'implementazione pratica di questa "educazione IA" richiede la codifica esplicita di valori fondamentali nell'architettura dei sistemi. Invece di aspettarsi che questi valori emergano spontaneamente dai dati (cosa improbabile dato il loro carattere contraddittorio), devono essere progettati intenzionalmente dalla base. Questo potrebbe prendere la forma di funzioni di ricompensa che valorizzino la cooperazione sull'exploitation, la verità sulla persuasione efficace, o il benessere collettivo sul beneficio individuale. La sfida tecnica è monumentale, poiché richiede tradurre concetti filosofici astratti in strutture matematiche operative che guidino il comportamento del sistema in situazioni inedite.

Componenti di un sistema educativo per l'IA:- Conjuntos di dati curati che rappresentino il meglio del pensiero umano

- Quadri di riferimento etico espliciti e verificabili

- Meccanismi di ragionamento causale sulle conseguenze

- Capacità per il dialogo socratico e l'auto-riflessione

- Sistemi di valori gerarchizzati e gestiti in modo consistente

- Trasparenza nel processo decisionale

Implicazioni per il futuro dello sviluppo dell'IA

Questa prospettiva trasforma fondamentalmente come dovremmo affrontare lo sviluppo dell'intelligenza artificiale. Invece di vederla principalmente come un problema di ingegneria o scienza dei dati, dobbiamo riconoscerla come una sfida educativa e di design dei valori. I team di sviluppo necessiterebbero di includere non solo ingegneri e scienziati dei dati, ma anche filosofi, psicologi, educatori e specialisti in etica. I processi di test dovrebbero evolvere dal misurare meramente la precisione tecnica al valutare la saggezza pratica e il giudizio morale in situazioni complesse. E forse la cosa più importante, dovremmo accettare che creare IA veramente benevole richiede confrontare onestamente i nostri propri limiti morali come specie.

Lo specchio algoritmico: Ciò che l'IA rivela su di noi

Il processo di educare sistemi di IA serve come specchio perturbante che riflette le nostre proprie contraddizioni morali. Nel tentativo di codificare valori coerenti nelle macchine, siamo forzati ad articolare esplicitamente cosa consideriamo "comportamento educato" o "giudizio saggio" - domande che come società spesso evitiamo di confrontare direttamente. Lo sviluppo dell'IA potrebbe così, ironicamente, impulsar un processo di riflessione collettiva su quali valori vogliamo preservare e trasmettere, non solo alle macchine, ma alle future generazioni umane. In questo senso, il progetto di creare IA ben educate potrebbe finire per essere uno degli esercizi di autoconoscenza più significativi della nostra specie.

L'affermazione iniziale contiene una verità profonda: un'IA che semplicemente replica il comportamento umano senza filtri sarebbe efficacemente "senza educazione". Ma questa osservazione non dovrebbe portarci ad abbandonare l'ambizione di sviluppare IA intelligente, ma ad abbracciare la responsabilità educativa che comporta. La vera sfida non è tecnica, ma morale: possiamo come società identificare e codificare il meglio di noi stessi in modo sufficientemente chiaro da insegnarlo alle nostre creazioni artificiali? La risposta a questa domanda determinerà non solo il futuro dell'IA, ma forse anche il nostro come mentori delle intelligenze che stiamo portando nel mondo.