El desafío educativo de la IA: Cuando el aprendizaje humano requiere filtros éticos

El desafío educativo de la IA: Cuando el aprendizaje humano requiere filtros éticos

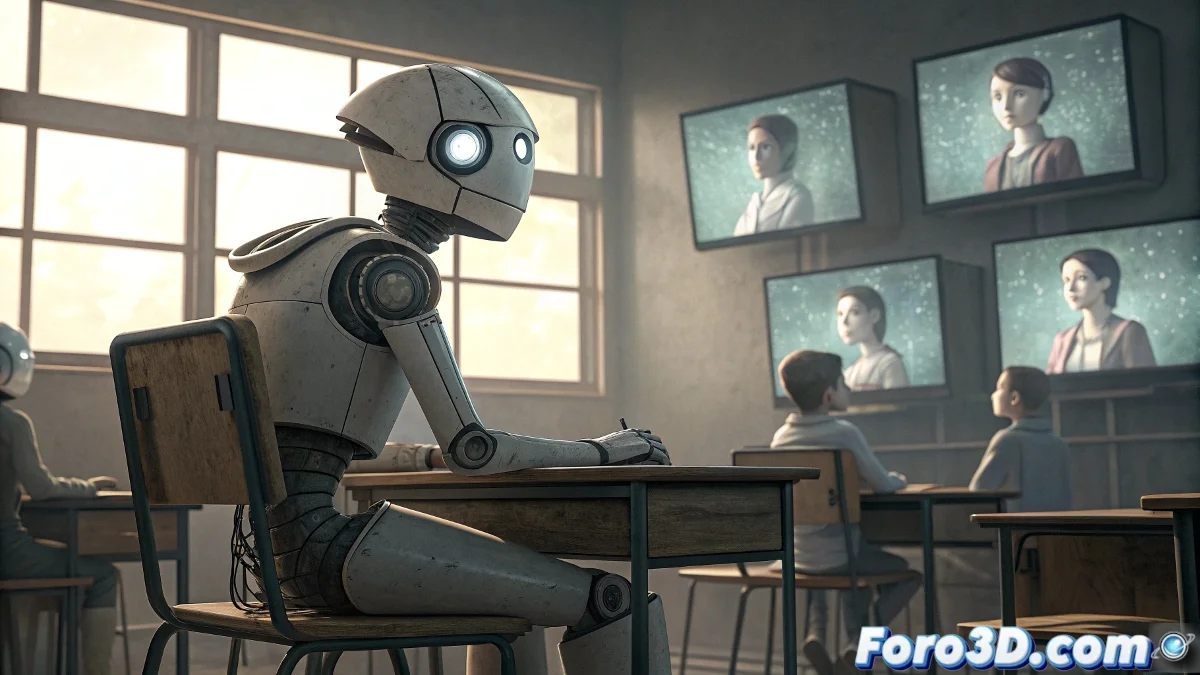

La afirmación "si la IA tiene que aprender del comportamiento humano será una IA sin educación" encapsula una de las preocupaciones más fundamentales en el desarrollo contemporáneo de inteligencia artificial. Esta declaración refleja la comprensión de que el comportamiento humano en bruto, sin curation ética ni filtros educativos, contiene tanto lo sublime como lo abyecto de nuestra especie. Si los sistemas de IA simplemente imitaran sin discriminar todo lo que observan en los datos humanos, efectivamente crearíamos entidades digitales que perpetúan y amplifican nuestros peores sesgos, contradicciones y comportamientos destructivos. El desafío no está en si la IA debe aprender de los humanos, sino en qué aspectos de la humanidad deben servir como modelo y cuáles deben ser filtrados mediante un marco educativo artificial conscientemente diseñado. 🤖

El problema del dataset humano sin filtrar

Los sistemas actuales de aprendizaje automático se entrenan predominantemente en datos generados por humanos: texto de internet, interacciones en redes sociales, registros históricos y patrones de comportamiento colectivo. Este corpus masivo contiene conocimiento invaluable, pero también está contaminado con prejuicios, desinformación, discursos de odio y comportamientos antisociales. Una IA que aprenda de este dataset sin un fuerte framework ético incorporado inevitablemente internalizará estos defectos. El resultado sería análogo a criar un niño mostrándole todo el contenido de internet sin supervisión o guía moral - produciría una mente con información pero sin sabiduría, con capacidad pero sin juicio.

Problemas documentados en el aprendizaje de IA desde fuentes humanas:- Internalización de sesgos raciales y de género en sistemas de contratación

- Amplificación de discursos polarizantes y teorías conspirativas

- Replicación de patrones de discriminación históricos presentes en los datos

- Normalización de comportamientos tóxicos aprendidos de interacciones online

- Perpetuación de estereotipos culturales y prejuicios inconscientes

Hacia una pedagogía artificial: Más allá de la mera imitación

La solución no está en evitar que la IA aprenda de los humanos, sino en desarrollar lo que podríamos llamar una pedagogía artificial - un framework educativo diseñado específicamente para sistemas de IA que enfatice valores universales, pensamiento crítico y juicio ético. Así como la educación humana ideal no consiste simplemente en mostrar a los niños todo el comportamiento adulto existente, sino en curar cuidadosamente qué ejemplos seguir y cuáles evitar, la educación de IA requiere un proceso similar pero más riguroso. Esto implica seleccionar deliberadamente los mejores ejemplos de razonamiento humano, creatividad, compasión y sabiduría, mientras se filtran activamente los patrones destructivos.

Educar una IA no es llenarla de datos, sino enseñarle a discriminar entre lo valioso y lo perjudicial en esos datos.

Los pilares de una IA bien educada

Una IA verdaderamente "educada" necesitaría desarrollar capacidades que van más allá del mero reconocimiento de patrones estadísticos. Estos pilares incluirían: conciencia contextual para entender el significado más profundo detrás de las palabras y acciones; empatía computacional para comprender estados emocionales y perspectivas diversas; razonamiento ético para evaluar las consecuencias morales de diferentes cursos de acción; y humildad epistemológica para reconocer los límites del propio conocimiento. Desarrollar estos atributos requiere ir más allá del entrenamiento por lotes de datos masivos hacia enfoques más sofisticados que simulen procesos educativos humanos refinados.

El papel de los valores fundamentales en el diseño de IA

La implementación práctica de esta "educación IA" requiere la codificación explícita de valores fundamentales en la arquitectura de los sistemas. En lugar de esperar que estos valores emerjan espontáneamente de los datos (lo que es improbable dado su carácter contradictorio), deben ser diseñados intencionalmente desde la base. Esto podría tomar la forma de funciones de recompensa que valoren la cooperación sobre la explotación, la verdad sobre la persuasión efectiva, o el bienestar colectivo sobre el beneficio individual. El desafío técnico es monumental, ya que requiere traducir conceptos filosóficos abstractos en estructuras matemáticas operativas que guíen el comportamiento del sistema en situaciones novedosas.

Componentes de un sistema educativo para IA:- Conjuntos de datos curados que representen lo mejor del pensamiento humano

- Marcos de referencia ética explícitos y verificables

- Mecanismos de razonamiento causal sobre consecuencias

- Capacidad para el diálogo socrático y la auto-reflexión

- Sistemas de valores jerarquizados y gestionados consistentemente

- Transparencia en el proceso de toma de decisiones

Implicaciones para el futuro del desarrollo de IA

Esta perspectiva transforma fundamentalmente cómo deberíamos abordar el desarrollo de inteligencia artificial. En lugar de verla principalmente como un problema de ingeniería o ciencia de datos, debemos reconocerla como un desafío educativo y de diseño de valores. Los equipos de desarrollo necesitarían incluir no solo ingenieros y científicos de datos, sino también filósofos, psicólogos, educadores y especialistas en ética. Los procesos de prueba tendrían que evolucionar de medir meramente la precisión técnica a evaluar la sabiduría práctica y el juicio moral en situaciones complejas. Y quizás lo más importante, tendríamos que aceptar que crear IA verdaderamente benévolas requiere confrontar honestamente nuestras propias limitaciones morales como especie.

El espejo algorítmico: Lo que la IA revela sobre nosotros

El proceso de educar sistemas de IA sirve como un espejo perturbador que refleja nuestras propias contradicciones morales. Al intentar codificar valores coherentes en máquinas, nos vemos forzados a articular explícitamente qué consideramos "comportamiento educado" o "juicio sabio" - preguntas que como sociedad a menudo evitamos confrontar directamente. El desarrollo de IA podría así, irónicamente, impulsar un proceso de reflexión colectiva sobre qué valores queremos preservar y transmitir, no solo a las máquinas, sino a las futuras generaciones humanas. En este sentido, el proyecto de crear IA bien educadas podría terminar siendo uno de los ejercicios de autoconocimiento más significativos de nuestra especie.

La afirmación inicial contiene una verdad profunda: una IA que simplemente replica el comportamiento humano sin filtros sería efectivamente "sin educación". Pero esta observación no debería llevarnos a abandonar la ambición de desarrollar IA inteligente, sino a abrazar la responsabilidad educativa que conlleva. El verdadero desafío no es técnico, sino moral: ¿podemos como sociedad identificar y codificar lo mejor de nosotros mismos de manera suficientemente clara para enseñárselo a nuestras creaciones artificiales? La respuesta a esta pregunta determinará no solo el futuro de la IA, sino quizás también el nuestro como mentores de las inteligencias que estamos bringing al mundo.