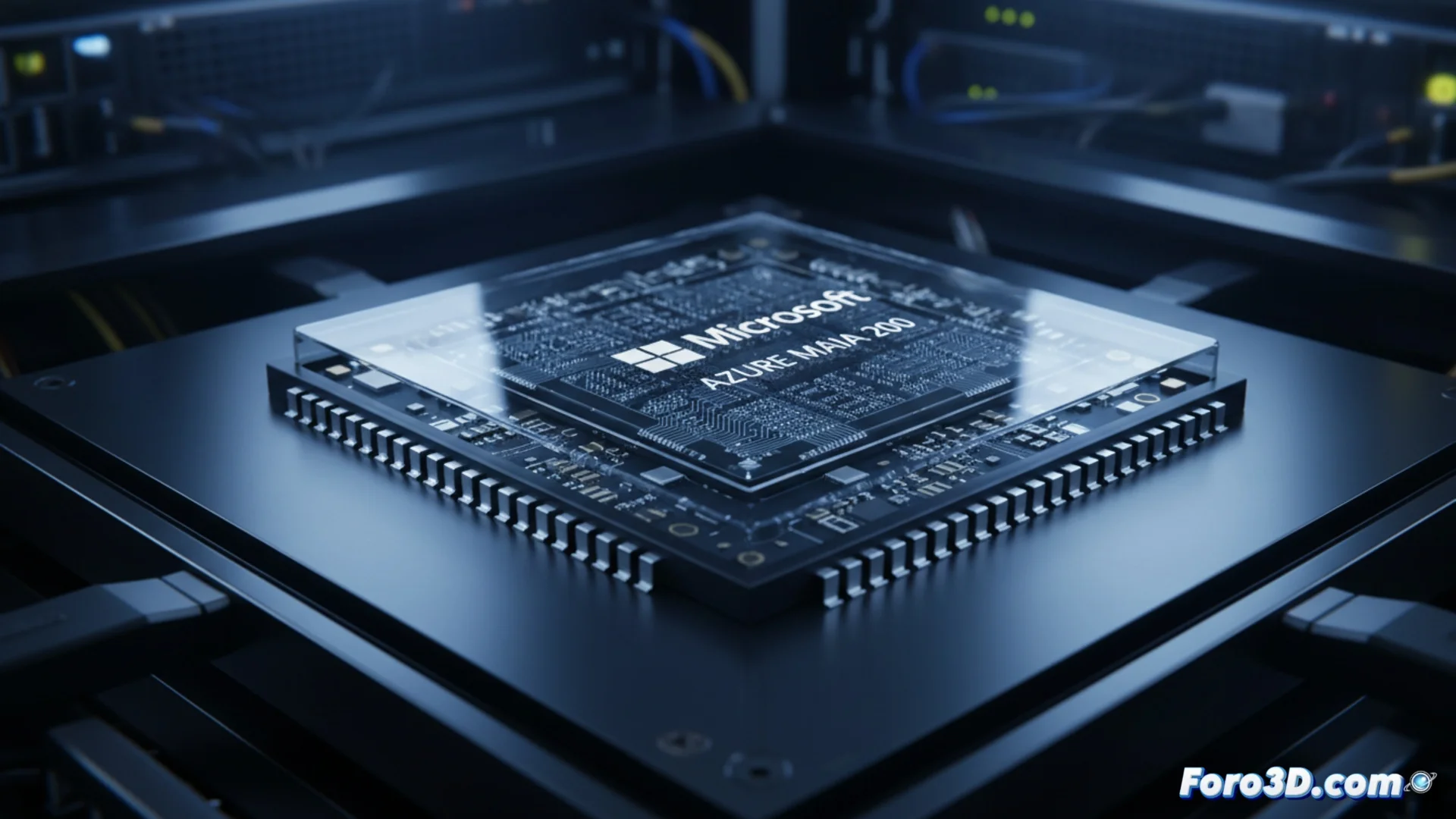

Microsoft stellt den KI-Beschleuniger Azure Maia 200 vor

Das Technologieunternehmen Microsoft hat seinen neuen KI-Beschleuniger Azure Maia 200 vorgestellt. Dieses Bauteil stellt die Weiterentwicklung in der Familie der Maia-Prozessoren dar, die speziell für den Einsatz in Servern entwickelt wurden. Seine Hauptaufgabe besteht darin, bereits trainierte KI-Modelle auszuführen, damit diese Antworten und Vorhersagen generieren. Microsoft entwirft diese Hardware, um diese Operationen mit hoher Geschwindigkeit und einem Effizienzniveau zu bewältigen, das laut dem Unternehmen derzeit die Angebote von Konkurrenten wie Amazon und Google in diesem Bereich übertrifft. 🚀

Fokus auf Effizienz und Geschwindigkeit für Inferenz

Der Azure Maia 200 wird mit dem Ziel hergestellt, zu optimieren, wie KI-Modelle in großem Maßstab auf der Azure-Cloud-Plattform ausgeführt werden. Durch die Herstellung des eigenen Chips strebt Microsoft eine direktere Kontrolle über die gesamte Kette von Hardware und Software an, was eine präzisere Anpassung ermöglicht, wie das System mit den Daten umgeht. Diese Methode zielt darauf ab, Wartezeiten zu reduzieren und die Energieverwendung bei der Ausführung komplexer Modelle zu verbessern, von großen Sprachmodellen bis hin zu Systemen, die Bilder analysieren. Das Unternehmen gibt nicht alle Details zu seiner Architektur preis, deutet aber an, dass das Design die Speicherkapazität und die Chip-Verbindungen priorisiert, um die enormen Parameter-Mengen aktueller Modelle zu verwalten.

Wichtige Merkmale des Azure Maia 200:- Entwickelt für die Ausführung von KI-Inferenzaufgaben mit hoher Geschwindigkeit.

- Zielt darauf ab, die Energieeffizienz in Rechenzentren zu verbessern.

- Architektur, die Speicherbandbreite und Interkonnektivität priorisiert.

Es scheint, als ob der neue globale Wettbewerb nicht mit Raketen, sondern mit Transistoren und damit ausgetragen wird, wer eine Anfrage zu Kätzchen schneller verarbeiten kann.

Das Wettbewerbsumfeld für KI-Silizium

Die Vorstellung des Maia 200 zeigt einen breiten Trend in der Technologiebranche, in dem große Cloud-Dienstleister eigene spezialisierte Chips entwickeln. Amazon verfügt über seine Prozessoren Inferentia und Trainium, während Google mit seinen Tensor Processing Units (TPU) arbeitet. Mit der Vorstellung des Maia 200 festigt Microsoft seinen Plan, eine eigene KI-Infrastruktur anzubieten, und konkurriert nicht nur bei Software-Diensten, sondern auch beim Leistungsverhalten der darunterliegenden Hardware. Das Unternehmen plant, diese Beschleuniger in seinen Rechenzentren weltweit zu implementieren, um Dienste wie Azure OpenAI Service und andere generative KI-Operationen voranzutreiben.

Hauptakteure bei Cloud-spezifischen Chips:- Microsoft: Azure Maia 200 für Inferenz.

- Amazon Web Services: Chips Inferentia und Trainium.

- Google Cloud: Tensor Processing Units (TPU).

Auswirkungen auf die Zukunft der Cloud-Computing

Dieser Schritt unterstreicht, wie der Wettlauf um die Vorherrschaft in der KI nun entscheidend vom maßgeschneiderten Silizium abhängt. Durch die Kontrolle sowohl von Software als auch Hardware möchte Microsoft seinen Kunden einen integrierteren und effizienteren Stack bieten. Das Endziel ist es, größere und komplexere KI-Modelle schneller und mit geringeren Betriebskosten zu verarbeiten und damit neue Leistungsstandards in der Cloud zu definieren. 🔌