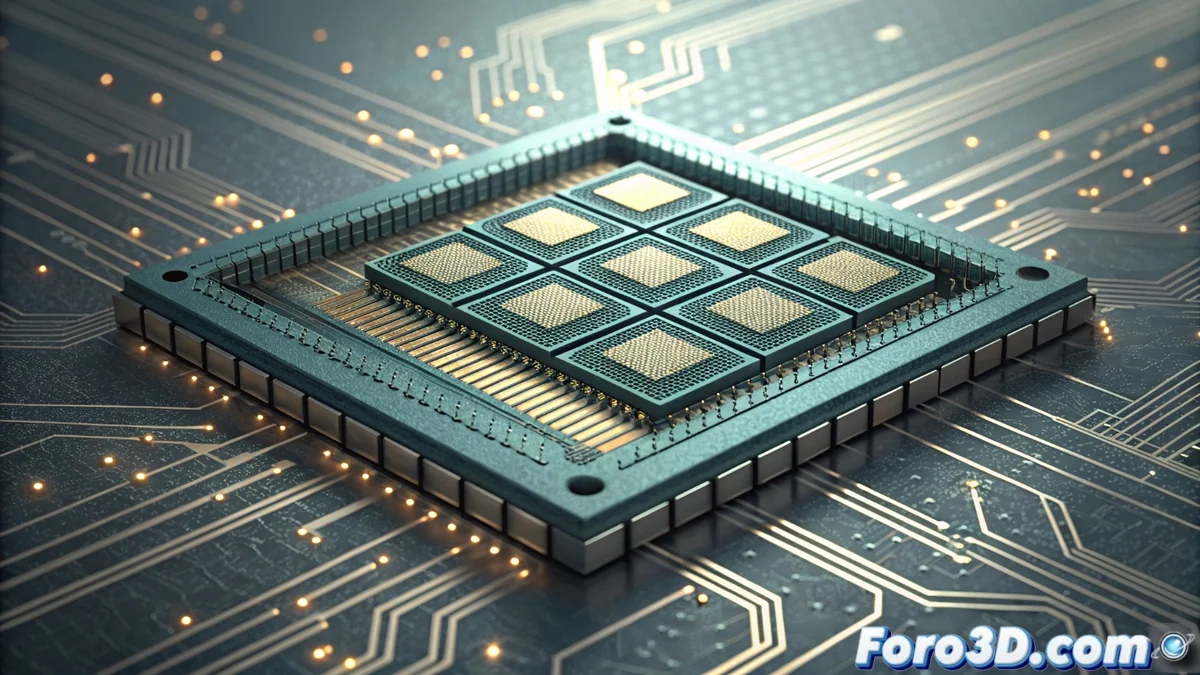

Die PIM-Architektur: Verarbeitung im Speicher als Revolution der Hardware

Das Hardware-Design erlebt eine radikale Transformation mit dem Aufkommen der PIM-Architektur (Processing in Memory). Dieses Paradigma stellt Jahrzehnte der Konvention infrage, indem es die Rechenlogik direkt in die Speichermodule integriert, sei es DDR oder die fortschrittlichen Stapel HBM (High Bandwidth Memory). Das Prinzip besteht darin, Operationen dort auszuführen, wo die Daten liegen, und die Notwendigkeit zu eliminieren, massive Informationsmengen über den Systembus zur CPU oder GPU zu transportieren. Dieser Wandel verspricht, den kritischsten Engpass der modernen Computertechnik zu lösen. 🚀

Transformierende Vorteile und Anwendungsfälle

Der Einfluss von PIM zeigt sich in zwei Schlüsseldimensionen: rohe Leistung und Energieeffizienz. Durch die drastische Reduzierung der Datenbewegung wird nur ein Bruchteil der Energie verbraucht, ein entscheidender Fortschritt für Rechenzentren und Supercomputing. Anwendungen, die große Datensätze verarbeiten, profitieren am meisten. Hier sinkt die Latenz dramatisch und die effektive Bandbreite vervielfacht sich.

Schlüsselanwendungsbereiche:- Maschinenlernen und KI: Beschleunigt das Training von Modellen und die Inferenz durch Verarbeitung von Datensatzmatrizen direkt im Speicher.

- Datenbankanalyse: Beschleunigt komplexe Abfragen sowie Filter- und Sortieroperationen in großen Informationsmengen.

- Wissenschaftliche Simulation und Rendering: Optimiert Aufgaben mit intensivem Zugriff auf Puffer und komplexe Geometrien, üblich in 3D-Grafik und CFD.

Die ultimative Ironie ist, dass nach Jahrzehnten der Optimierung von CPUs, um Daten schneller zu bewegen, die Lösung darin besteht, sie gar nicht zu bewegen.

Hindernisse auf dem Weg zur Adoption

Trotz ihres Potenzials ist die Implementierung von PIM nicht frei von tiefgreifenden Herausforderungen. Sie erfordert eine vollständige Neuerfindung der Speicherhierarchien und der Software, die sie verwaltet. Entwickler benötigen neue Programmiermodelle und Tools, um diese dezentralisierte Verarbeitung zu nutzen.

Haupt-Herausforderungen zu überwinden:- Design-Komplexität: Die Integration von Rechenlogik in dichte Speicherchips wirft Probleme bei Fertigung, Wärmeableitung und Zuverlässigkeit auf.

- Software-Ökosystem: Es werden neue Compiler, Bibliotheken und Frameworks benötigt, die die Hardware-Komplexität für Programmierer abstrahieren.

- Systemarchitektur: Die Koordination zwischen CPU, GPU und mehreren PIM-Einheiten im Speicher erfordert neue Designs für Verbindungen und Kohärenz.

Die Zukunft und aktuelle Implementierungen

Die Industrie schreitet bereits mit Prototypen und ersten Lösungen voran und zeichnet einen irreversiblen Weg vor. Unternehmen wie Samsung mit ihren HBM-PIM-Speichern sowie Giganten wie AMD und Intel mit Architekturen, die verwandte Konzepte erkunden, führen diese Hybridisierung zwischen Speicher und Verarbeitung an. Dieser konzeptionelle Wandel, den Von Neumann wahrscheinlich nicht vorhergesehen hat, definiert die Grundlagen der Computertechnik neu und priorisiert die DatenNähe über die Transportgeschwindigkeit. Die Zukunft der Hardware wird zweifellos integrierter und effizienter sein. 💡