Última edición por Reaversword; 23-07-2010 a las 20:39

Pues todavía no han dicho si es GPU o CPU, pero algo presentan los de nl. http://www.youtube.com/watch?v=hhyrroqaizm.

Supongo que después de la feria harán el anuncio completo. Saludos.

Luis.

En la vida solo hay dos cosas seguras: la muerte y los impuestos.

Vaya, veo que no me equivocaba. Gracias por el vídeo de vista (o Luis, como gustes). Espero que sea una actualización, como hicieron con LuxRender o Indigo y no lo quieran vender como producto nuevo, está claro como el agua que es un añadido a Maxwell que la verdad, elimina el único punto flaco que tenía el software. Esperemos que compitiendo con su mayor rival, Fryrender (o Arion, menuda guarrada lo de venderlo como producto nuevo y abandonar a toda la comunidad creada), Next Limit haga que Maxwell use GPU+cpu+red también.Pues todavía no han dicho si es GPU o CPU, pero algo presentan los de nl. http://www.youtube.com/watch?v=hhyrroqaizm.

Supongo que después de la feria harán el anuncio completo. Saludos.

Luis.

Bueno, parece que no estáis muy colaborativos, pero hey, que hasta podéis acertar. Nadie más se anima a predecir algo?

Ma agrada mucho este evento, desafortunadamente para mí no he savido de que hagan uno de cerca de dónde estoy, si no haría un exfuerzo por ir por que considero que es un evento muy interesante.

-------------------------------------------------

Todo lo que hagamos hoy tiene eco en la eternidad

-------------------------------------------------

The video shows our new interactive engine, that Will be oficially announced in a few days. Stay tuned, son we Will give you more información. For now i just can say is that it Will be free for all Maxwell v2 users Juan de nl Dixit. Saludos.

Luis.

Posdata:

Puedes usar el que quieras Luis o de vista.

En la vida solo hay dos cosas seguras: la muerte y los impuestos.

Ahí va mi porra: Autodesk compra Unity.

Ahora sí que se me ha puesto dura. Gracias de nuevo.The video shows our new interactive engine, that Will be oficially announced in a few days. Stay tuned, son we Will give you more información. For now i just can say is that it Will be free for all Maxwell v2 users Juan de nl Dixit. Saludos.

Luis.

Posdata:

Puedes usar el que quieras Luis o de vista.

Devista, dónde has leído la cita que has publicado? La verdad, pillé el Maxwell 2 con la promoción del mundial, y aún no me he mirado el tema del foro como usuario de pago, voy a ver si muevo el tema.

Wevon, Unity era el engine de juegos que ha día de hoy competía -un poco por debajo- Con el UDK de Epic, ¿no?

Sería arriesgado por parte de Autodesk, más aún si pretenden venderlo estando UDK gratis, pero quien sabe cómo lo modificarían para llamar la atención. Desde luego un motor de render en tiempo real que tenga un aspecto aceptable sí podría ser interesante, especialmente con el tema del Raytracing en tiempo real, quien sabe?

Última edición por Reaversword; 26-07-2010 a las 18:56

Pues, nada, buscando por YouTube por Siggraph 2010, aquí un resumen: http://www.youtube.com/watch?v=-pmf3xrwpko.

Nuevas tecnologías: http://www.youtube.com/watch?v=yw9b3glxusu.

Aquí el sacamagras del 2010: http://www.youtube.com/watch?v=3vljmworrwk.

Vosotros decidís, gimnasio o parametric reshaping.

Blur en tiempo real: http://www.youtube.com/watch?v=rbca1...eature=related.

Sonido en tiempo real para fracturas: http://www.youtube.com/watch?v=nh8n_lnzzi.

Burbujas: http://www.youtube.com/watch?v=kmsc48e41aq.

Mezclador de mallas (que practico). http://www.youtube.com/watch?v=sjqks6ucz0i.

Pantalla cilíndrica (360º de visión). Holograma? (putada, 8 renders/frame desde ahora). http://www.youtube.com/watch?v=inlyxhkdqwg.

Última edición por Reaversword; 27-07-2010 a las 19:39

Nota oficial sobre el Maxwell realtime preview presentado en el Siggraph 2010. http://www.maxwellrender.com/pdf/max...eview_info.pdf. Saludos.

Luis.

En la vida solo hay dos cosas seguras: la muerte y los impuestos.

Decepcionante.Nota oficial sobre el Maxwell realtime preview presentado en el Siggraph 2010. http://www.maxwellrender.com/pdf/max...eview_info.pdf. Saludos.

Luis.

No funciona por GPU, solo CPU.

Según nl, la tecnología Cuda es muy potente, pero no es adecuada para render. Y que además necesita de costos as soluciones de GPU.

Alucino con la burrada que suelta esta gente y tan frescos que se quedan para justificarse. Si, una GeForce 480GTX es bastante cara, 600 euros aproximadamente, pero es 10 veces más rápida que un Dual Xeon de 4000EUR, vamos que es muy caro invertir en GPU (nótese la ironía).

Que les digan a Fryrender/Arion, o a Octane, thea, Mental mill, que el render por GPU no mejora los tiempos, me parto de la risa.

Lo que está claro es que por CPU necesitas comprar 10 licencias para tener el mismo rendimiento que una licencia por GPU (y eso no es negocio para ellos).

Hombre Cabfl, estoy decuerdo en que es un poco ridículo que marketing haya decidido vender (que no se vende, es un upgrade gratuito) el preview engine como que no hay que comprar caras tarjetas gráficas que se quedan obsoletas en 6 meses, más que otra cosa porque cuando salga Maxwell render con GPU (o CPU + GPU) entonces tendrán que hacer un comunicado ignorando este, pero, recuerda que Vray RT (que también va por CPU, al igual que Vray normal) es un producto a parte, y a parte vienen a ser 250 euros + iva.

Next limit dice básicamente lo mismo que ChaosGroup, sí al GPU, pero no a costa de obligar a la gente a comprar una Nvidia, es decir, cuando OpenCL esté listo, y que la gente elija su producto.

Me pregunto si Nvidia se esperaba esta rebeldía por parte de algunas compañías, jodé, al final fueron Nvidia quien se curró el Cuda.

No he criticado que sea un software aparte, integrado, que se pague o no nueva licencia. Lo que critico es las mentiras que sueltan para justificar su software por CPU, en vez de por GPU como el resto de competencia. Decir que no lo van a lanzar por GPU por que según ellos no es una tecnología adecuada, me parece un engaño, además de dejar colgados a sus usuarios, además, se excusan en el precio de las tarjetas gráficas, pero es que, el mismo rendimiento se necesitan 10 CPU que cuestan 20 veces más.

Me parece una tomadura de pelo, siendo además líderes en el mercado de motores de render unbiased. Se han dormido en los laureles, y en vez de ponerse las pilas para actualizar su software a GPU, prefieren engañar a la peña y seguir vendiendo licencias CPU el vrayrt funciona por CPU por que en su momento la tecnología GPU y las gráficas aún no estaba preparada, pero ahora ya es el momento y próximamente por GPU.

Randomcontrol han hecho una jugada no muy limpia, al vender el Arion como licencia separada de Fryrender, pero por lo menos se han subido rápido a la nueva tecnología, en vez de negar lo evidente.

Y aparecen nuevas alternativas como thea y Octane, que dejan a Maxwell obsoleto en términos de velocidad.

No han dicho que GPU no sea la tecnología adecuada. Lo que han dicho es que GPU a través de Cuda no es la tecnología apropiada, y que lo será cuando OpenCL sea una realidad. Además, queda otra cuestión, pero la dejo para el final.

En lo que estamos de acuerdo es en que enfocar el tema como no hace falta comprar caras tarjetas gráficas es una gilipollez, todos nos hemos gastado un huevo en procesadores y tenemos claro cuánto vale qué. Se han limitado a decir que funcionara en cualquier procesador moderno. Lo que no sabemos en cómo funcionara, pero bueno, ya veremos.

La verdad es que vrayrt tiene que estar a punto de caramelo para el GPU, a ver qué pasa con el vrayrt de Autodesk Maya, aunque hasta dónde sé, hasta que OpenCL no sea una realidad, al igual que Next Limit, no moverán ficha.

Respecto a random control, no es una opción, al menos para mí de momento, no me da confianza, la verdad.

De todas maneras, todos sabemos que el render por GPU tiene un problema gordísimo, y es la memoria. Hoy en día con 2 gigas que narices renderizas, como tu proyecto no sea un producto único, porque como haya que tirar para lante un proyecto de 500 texturas con 2 Gb.

Probablemente está sea la mejor razón por la que ni ChaosGroup ni Next Limit venden este tipo de producto aún.

Última edición por Reaversword; 09-08-2010 a las 17:24

Aquí la presentaciones de ChaosGroup: http://www.cGarchitect.com/news/newsfed.asp?Nid=4970. Estoy viendo los vídeos ahora mismo, podéis ver cómo han preparado el motor de render para crear estereoscopia sin necesidad de lanzar dos renders diferentes, dispersión de la luz, Vray RT para Autodesk Maya, Vray RT a través de cpu+GPU, y el simulador de fuego de ChaosGroup, Phoenix (para max).

Última edición por Reaversword; 11-08-2010 a las 12:30

Muy interesantes esos videos, Reaversword. La beta de vrayrt v2, muestra que 3 gráficas gf480GTX, son 15-25 veces más rápidas que un i7 980x (6 Cores + HT a 3,6 Ghz).

También bien de las limitaciones de la cantidad de Ram de las gráficas, y cómo automáticamente bajan la resolución de las texturas cuando es necesario. En este caso están usando tarjetas domésticas con 1,5 Gb de memoria, pero hay tarjetas tesdla con 3 y 6 Gb de memoria, y las nuevas Quadro con 2 - 6 Gb. Habría que ver cuanta cantidad de texturas y geometría aguantan.

Cierto que con 3 Gb de memoria local, sigue siendo poco para proyectos de gran tamaño. Equivaldría a un render con CPU con 4 Gb de Ram (1 Gb se descuenta, por que la gráfica no carga el Windows+3dsmax+la aplicación de render, solos datos de geometría y texturas), pero también es cierto que hoy día nos hemos acostumbrados a tener 8-16 Gb de Ram en nuestras equipos, y ya nadie optimiza el tamaño de las texturas, y metemos mucha más resolución de textura de la necesaria. Recuerdo no hace muchos años, cuando optimizabamos todo.

Me ha sorprendido que usa exclusivamente GPU, mientras que otros como Arion, usan la suma de GPU + cpus.

En el caso del vrayrt, la CPU solo gestiona, y usa un solo Core, así que, la mejor configuración sería un Dual Core + 4 tarjetas gráficas potentes con mucha memoria local.

A ver si alguien que entienda bien el inglés del video, nos puede aclarar algunas cosas:

En el interfaz del vrayrt (3ds Max) tiene 3 opciones: CPU, OpenCL (singlekernel), OpenCL (multikernel).

1º si con la opción OpenCL (singlekernel) esta usando 3 tarjetas GeForce480GTX, ¿para qué es la opción de OpenCL (multikernel)? Responden a esta pregunta al final del video.

2º porqué pone OpenCL, si luego resulta que consulta una ventana de Cuda para mostrar las características del sistema GPU. En alguna parte del video aclara si esta usando OpenCL o Cuda?

Después de ver estos videos donde se demuestra la enorme ventaja de calcular por GPU, creo que nextlimits se han dormido y Maxwell llegara el último.

Y mientras a engañar a los usuarios para que sigan comprando sus licencias CPU.

Si actualmente tenemos tarjetas de hasta 2-6 Gb de Ram local, la próxima generación tendrá posiblemente 8 Gb o más (10-12 Gb?), y apenas hay un año entre generación y generación. Así que el render por GPU es el presente, y las empresas que desarrollan motores de render deberían ir lanzando ya sus primeras versiones, para que en un año sus motores de render GPU estén maduros.

Última edición por cabfl; 11-08-2010 a las 17:41

Vaya pero que burrada.Muy interesantes esos videos, Reaversword. La beta de vrayrt v2, muestra que 3 gráficas gf480GTX, son 15-25 veces más rápidas que un i7 980x (6 Cores + HT a 3,6 Ghz).

También bien de las limitaciones de la cantidad de Ram de las gráficas, y cómo automáticamente bajan la resolución de las texturas cuando es necesario. En este caso están usando tarjetas domésticas con 1,5 Gb de memoria, pero hay tarjetas tesdla con 3 y 6 Gb de memoria, y las nuevas Quadro con 2 - 6 Gb. Habría que ver cuanta cantidad de texturas y geometría aguantan.

Cierto que con 3 Gb de memoria local, sigue siendo poco para proyectos de gran tamaño. Equivaldría a un render con CPU con 4 Gb de Ram (1 Gb se descuenta, por que la gráfica no carga el Windows+3dsmax+la aplicación de render, solos datos de geometría y texturas), pero también es cierto que hoy día nos hemos acostumbrados a tener 8-16 Gb de Ram en nuestras equipos, y ya nadie optimiza el tamaño de las texturas, y metemos mucha más resolución de textura de la necesaria. Recuerdo no hace muchos años, cuando optimizabamos todo.

Me ha sorprendido que usa exclusivamente GPU, mientras que otros como Arion, usan la suma de GPU + cpus.

En el caso del vrayrt, la CPU solo gestiona, y usa un solo Core, así que, la mejor configuración sería un Dual Core + 4 tarjetas gráficas potentes con mucha memoria local.

A ver si alguien que entienda bien el inglés del video, nos puede aclarar algunas cosas:

En el interfaz del vrayrt (3ds Max) tiene 3 opciones: CPU, OpenCL (singlekernel), OpenCL (multikernel).

1º si con la opción OpenCL (singlekernel) esta usando 3 tarjetas GeForce480GTX, ¿para qué es la opción de OpenCL (multikernel)? Responden a esta pregunta al final del video.

2º porqué pone OpenCL, si luego resulta que consulta una ventana de Cuda para mostrar las características del sistema GPU. En alguna parte del video aclara si esta usando OpenCL o Cuda?

Después de ver estos videos donde se demuestra la enorme ventaja de calcular por GPU, creo que nextlimits se han dormido y Maxwell llegara el último.

Y mientras a engañar a los usuarios para que sigan comprando sus licencias CPU.

Si actualmente tenemos tarjetas de hasta 2-6 Gb de Ram local, la próxima generación tendrá posiblemente 8 Gb o más (10-12 Gb?), y apenas hay un año entre generación y generación. Así que el render por GPU es el presente, y las empresas que desarrollan motores de render deberían ir lanzando ya sus primeras versiones, para que en un año sus motores de render GPU estén maduros.

Para que comprar si lo puedo tener gratis el mejor unbiased como el LuxRender.

Si quieren vivir engañados déjalos a esos lols.

Cabfl. Creo que las opciones no son singlekernel o multikernel, sino singlechannel o multichannel, por si vas a hacer compositing con el resultado.

Estos de ChaosGroup son unos cachondos (lo pongo recordando de cabeza):

Tenemos aquí está caja negra abierta, para que veáis lo que hay dentro, 3 GeForce 480 y un sólo procesador Intel extreme de 6 Cores, no toquéis las tarjetas que lamentablemente en unas presentaciones en Alemania hemos tenido dos muertos y varios heridos.

Vamos a presentar Vray for Maya, luego Phoenix, pdpplayer, y luego cerveza, vino y a beber.

Y por último en la presentación de pdpplayer. Con que previsualizais vuestras animaciones? -con Fchek, ya, y varias a la vez, para comparar? Lo compongo en After Effects. Ya, y mientras renderizas, err, voy a comer. Cuantas veces comes al día?

Mención especial de cuando están cambiando los colores de la furgoneta antigüa, después de ponerla de color rosa: esto, no. Definitivamente este no es el color.

Por no hablar del vídeo del coche deportivo: seguro que ha todos os ha pasado cuando llega vuestro director técnico y os dice, es que ese no es exactamente el tono de rojo que buscamos (pone otro tono de rojo), bueno, quiźa ligeramente amarillo (lo vira al amarillo), no, en realidad lo quiero verde. Seguro que todos vosotros sabéis de lo que hablo.

Espectacular.

Que sí, si estamos de acuerdo, que las gráficas son mucho más rápidas, si yo también quiero esa tecnología funcional ya, pero las tesla exige desenroscarse un riñón, un ojo y un huevo. Eso sí, podemos ahorrarnos la caldera de la calefacción de la casa con los apaños adecuados.

Tío, no seas tan duro con Next Limit, si por algo se caracterizan es por tener productos que funcionan sólidos como rocas. Seguro que han investigado la tecnología de rendering por GPU, pero aún no han visto por conveniente sacarlo (fíjate que en 2009 Chaos ya tenía algo funcional y tampoco sacó vrayrt por GPU).

Chaosgroup también ha comentado además de la auto-compresión de las texturas (elegante de cojones, la verdad, lo previsualizas y luego en el render final todo correcto), que hay ciertos Shaders que necesitan tomar decisiones lógicas, y que a las GPU de momento no se les da bien, han dejado caer que esperan que las GPU avancen, y en definitiva, que hay ciertos Shaders que necesitan una CPU para funcionar correctamente. Han comentado que no hay displacement (qué curioso, ahora que directx11 presume de ser una de las mayores novedades en traer), y que, aunque el Depth of Field va bien, el Motion Blur es prácticamente inviable. Que aún queda mucho por hacer, que están trabajando con el environment Fog. (pues sí que me he quedado con el cante, así todo de carrerilla).

Ah. Y sorpresa en el hilo de Vray for Maya.

Cierto que son caras, pero mucho más baratas que una granja de render por CPU.Que sí, si estamos de acuerdo, que las gráficas son mucho más rápidas, si yo también quiero esa tecnología funcional ya, pero las tesla exige desenroscarse un riñón, un ojo y un huevo. Eso sí, podemos ahorrarnos la caldera de la calefacción de la casa con los apaños adecuados.

Un Dual Xeon (6+6cores) y 12 Gb de Ram, y una gran fuente de alimentación, te puede costar 5000 euros.

Un Core i7 930 (4 Cores) + 12 Gb de Ram + Quadro FX470 + 2x tesla c2050 3 Gb + fuente 1200w, te cuesta en Azken 6000 euros.

Si compras las 2 tarjetas y te montas tu el equipo, te saldrá por menos, posiblemente 5400 euros.

Es una pasta, pero hablamos de un equipo que es al menos 10 veces más potente que el Dual Xeon, y la diferencia de precio es de 1000 euros o menos, y solo una licencia de render.

El equivalente en rendimiento en equipos Dual Xeon, serían 10 por 5000 euros = 50.000 euros (a esto suma el coste de 10 licencias de nodos de render).

En vrayrt todavía tiene limitaciones, pero es que, es una versión prerelease. Aún no es versión comercial y, además cuando lo lancen, será 1ª versión. Y ya sabes cómo es esto cuando lanzan una herramienta nueva, hasta 2 o 3 versiones después no suele empezar a alcanzar la madurez.

En Arion, parece que soporta todo igual que Fryrender, luego las limitaciones de vrayrt, se deben más a su diseño, que al propio GPU.

La memoria local es sin duda una limitación, y habrá que aprender a optimizar las escenas y las texturas. Pero seguro que en la próxima generación de tarjetas tendrán más memoria local, así que, creo que las CPU están listas para sentencia, y llega el momento de las GPU.

O no, por que este mundo no para de avanzar nunca, y cuando menos lo esperamos nos sorprenden con nuevas tecnologías.

Intel acaba de desarrollar una tarjeta con 32 Cores y 128 hilos, basado en x86, que trabaja como coprocesador de cálculo ayudando al CPU. Además, tiene la ventaja de que al ser x86, no necesita optimizar el software, y cualquier motor de render que funciona en un CPU, también podría funcionar en cpu+coprocesadores: http://www.fudzilla.com/processors/p...specifications.

Las demos actuales son con una tarjeta con un coprocesador de 32cores fabricado en 45nm a 1,2 GHz. Pero hablan de una futura versión de 50 Cores a 22nm (que seguramente ira además a más Mhz).

La principal desventaja de Intel, es que todavía tardarán 18-24 meses en tener su producto comercial listo, mientras que la tecnología GPU se vende ya.

Aquí un análisis comparando ambas soluciones cpu+coprocesador vs GPU fermi (Nvidia). http://www.hpcwire.com/features/comp...64.html?Page=1.

De nextlimits, lo que me molesta es que se excusen intentando convencer a la gente de que el GPU no es el camino a seguir (por que ahora no les interesa) y dentro de un par de años nos venderán el Maxwell por GPU. Y además hablan del precio de trabajar por GPU, cuando es mucho más barato que una granja por CPU.

Me suena al marketing estilo Apple, que lo que hoy es muy malo por que ellos no lo tienen, mañana es lo mejor del mundo por que ya lo tienen (y además intentaran venderlo como revolucionario e innovador).

Última edición por cabfl; 11-08-2010 a las 23:07

Muy interesante lo de Intel. A ver si se van dando cuenta que después de la disputa con Nvidia, se pueden comer un terreno que no siempre ha sido suyo, pero así, tranquilamente. Seguro que la gente de Intel, ha día de hoy tienen más que preparados los procesadores de dentro de 4 o 5 años, y van vendiendo poco a poco. Mientras se les siga metiendo caña, mejor para nosotros.

Cabfl, sabes si Arion va por Cuda? Supongo que las limitaciones de ChaosGroup vienen porque al OpenCL le queda aún para el desarrollo. Sí, como dices, es cuestión de tiempo.

Yp prefiero soluciones como las que está proponiendo Intel a las GPU de Nvidia/ati, para los desarrolladores es un gran problema tener que rediseñar programas que requieren mucha memoria a las características de una GPU, en cuanto una arquitectura elimine esas barreras se hará con el mercado.Intel acaba de desarrollar una tarjeta con 32 Cores y 128 hilos, basado en x86, que trabaja como coprocesador de cálculo ayudando al CPU. Además, tiene la ventaja de que al ser x86, no necesita optimizar el software, y cualquier motor de render que funciona en un CPU, también podría funcionar en cpu+coprocesadores: http://www.fudzilla.com/processors/p...specifications.

Un saludo

Houdini Addict

Powered by UNIX

If it looks good enough, it's good!

Parece que, aunque Chaos esté haciendo las cosas a través de OpenCL, comentan por el foro de Vray que aun así, continúan usando Nvidia debido al bajo soporte de OpenCL que tiene Ati de momento.

Lo cierto es que me sorprende, hace ya más de una año que se empezó a hablar del OpenCL, y Ati aún no está dejándose las pelotas para darse a sí misma un empujón en ese campo. No lo entiendo, está muy bien ser la pera limonera en tema de juegos, pero no entiendo cómo no van más adelantados en este campo, o es que ha sido el OpenCL (y el Cuda) lo que realmente supuso el retraso de la fermi de Nvidia y ahora es cuando se nota el porqué?

Aqui quiero poner una imagen bonita de mi pagina, pero no puedo...ojete.

En el interfaz del vrayrt (3ds Max) tiene 3 opciones: CPU, OpenCL (singlekernel), OpenCL (multikernel).Tú llevabas razón Cabfl, era kernel, no channel. Lo he estado viendo en el rt de Maya. Mis disculpas, va siendo hora de pillarse un monitor full Hd, por lo de leer mejor las letras.Cabfl. Creo que las opciones no son singlekernel o multikernel, sino singlechannel o multichannel, por si vas a hacer compositing con el resultado.

Pues entonces la pregunta sigue en el aire: ¿Qué diferencia habrá entre uno y otro?

Ok, ya me he enterado. El multi kernel es para quien quiera programar sombreadores por GPU (GPU Shaders), como, por ejemplo, texturas procedurales. Aunque aún está la cosa verde.Pues entonces la pregunta sigue en el aire: ¿Qué diferencia habrá entre uno y otro?

Ok, ya me he enterado. El multi kernel es para quien quiera programar sombreadores por GPU (GPU Shaders), como, por ejemplo, texturas procedurales. Aunque aún está la cosa verde.

Disney ha mostrado en SIGRAPH 2013 sus avances en la investigación llamada aireal, una nueva tecnología de bajo coste que permite realizar cualquier movimiento en la pantalla con simples gestos en el aire, la tecnología haptica es altamente escalable e incluso ofrece sensación de estar tocando los objetos gracias a su emisor de aire gradual.

Aireal permite que los usuarios sientan los objetos virtuales, experimentando la retroalimentación sobre los gestos del cuerpo entero, todo ello sin que el usuario tenga qué usar un dispositivo físico.

Aireal está diseñado para utilizar un vórtice, un anillo de aire que puede impulsar a grandes distancias mientras se mantiene su forma y velocidad constante, cuando el vórtice golpea la piel del usuario, el sistema de baja presión en el interior de un vórtice colapsa e imparte una fuerza qué el usuario puede sentir.

La tecnología aireal es casi en su totalidad en 3D, en el siguiente vídeo podemos ver cómo funciona, modelando y jugando, además de una explicación sobre el funcionamiento del aparato en sí.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Hola a todos.Tienen previsto acudir a SIGRAPH 2016? Vamos a estar presentes en el both número 461 de SideFX con cuatro presentaciones sobre proyectos de Houdini, renderizados en la nube a través de la plataforma GridMarkets.

El Miércoles, día 27 de julio tendremos al artista Kevin Mack, que hablará sobre su proyecto de realidad virtual en su presentación titulada Virtual Reality Art and The Future". También presentará GeoSim, con una charla sobre cómo crear ciudades enteras en 3D: Creating Real 3D Cities for Film, tV and GameDev using Houdini".

Si están ocupados el Miércoles, tenemos dos presentaciones más el Martes, día 26 de julio: Phill Mayer, artista de Houdini en The Mill, nos comentará cómo realizar simulaciones detalladas de tinta en agua, mientras que Jef Ranasinghe, Supervisor de VFX, nos comentará sus ideas sobre Dep rendering, dependencias y generación automática de películas en la nube.

Más detalles aquí: https://www.sidefx.com/news/houdini-at-Siggraph-2016/.

Nos gustaría mucho conocerles a todos en persona, así que, vengan a pasarse un rato en el both de SideFX.

Patricia y el equipo de GridMarkets

Última edición por PatriciaCornet; 24-07-2016 a las 18:16

Gracias por la información Patricia, lástima no poder ir.

|Agradecer cuando alguien te ayuda es de ser agradecido|

El siguiente vídeo es un adelanto de lo que podemos ver en el siguiente Siggraph celebrado en Asia de este año 2016.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Hola chicos. He estado por Siggraph en Los Angeles invitado por Autodesk. Hemos presentado novedades que vienen a 3dsmax, también la versión Indie de 3dsmax y Maya (por 20$ al mes), Bifrost Graph para Maya y max, y he visto un montón de nuevas tecnologias, como project Lativa de Chaos group, Omniverse de Nvidia, Blender 2.8, y hardware, aquí un resumen en video:

SIGGRAPH se celebrará mediante conferencia virtual, los responsables han decidido cancelar el evento de forma presencial ante el Covid-19, en principio estaba programada para celebrarse desde el 19 al 23 de julio, pero ahora no se sabe todavía las fechas finales, aunque puede que estas se respeten.

SIGGRAPH es otra más que se pasa a engrosar la lista de eventos cancelados por el mismo motivo, aunque hay que decir, que todas encuentran la misma solución dentro de sus posibilidades, y es celebrarlo online. No hay más datos hasta la fecha, cuando sepamos algo más, lo comentaremos aquí, para los interesados en seguir el evento online.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Siggraph abre sus puertas virtuales y nos descubre cómo seguir el espectáculo, parte del contenido estará disponible bajo demanda, la próxima semana estarán acompañados de sesiones en directo, que permitirán, por ejemplo, hacer preguntas a las personas que presentan este contenido y será posible seguir viendo todo el contenido hasta el 27 de octubre.

Si aún no tienes acreditación y estás pensando en verlo, todavía es posible hacerlo. Una vez registrado, tendrá acceso a un conjunto de contenido más o menos amplio dependiendo de su tipo de acreditación.

En el corazón de esta edición se encuentra la "Experiencia Virtual", una interfaz a través de la cual se puede navegar por el espectáculo.

El siguiente vídeo muestra una lista de secciones correspondientes a los principales componentes del evento, un perfil y herramientas sociales para redes, soporte cuando sea necesario, y por supuesto un sistema de calendario para grabar las sesiones en directo que le interesen: el conjunto es muy completo. Ten cuidado, sin embargo, todos los horarios son en la hora del Pacífico (hora de Los Angeles). Así que no olvides de hacer la conversión horaria, y utilizar el sistema de visualización bajo demanda si una sesión se emite a horas que no puedes verla.

|Agradecer cuando alguien te ayuda es de ser agradecido|

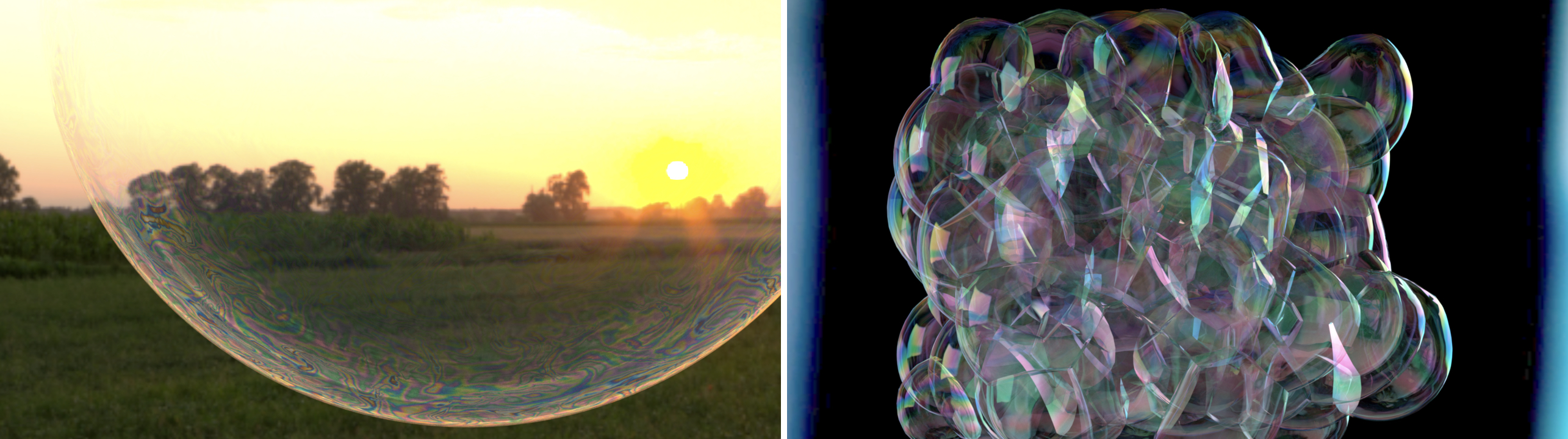

Proyecto de investigación presentado para el evento Siggraph, se trata de la animación de burbujas, algo que al parecer no es nada sencillo si se busca realismo y dinamismo.

Investigaciones previas sobre animaciones de burbujas de jabón, películas y espumas se centran en gran medida en el movimiento y la forma geométrica de la superficie de la burbuja. Estas obras descuidan la evolución del grosor de la burbuja, que normalmente es responsable de fenómenos visuales como vórtices superficiales, patrones de interferencia de Newton, ondas capilares y rotura de películas en una espuma dependiente de la deformación.

En este artículo, modelamos estos fenómenos naturales introduciendo el grosor de la película como un grado reducido de libertad en las ecuaciones Navier-Stokes y derivando sus ecuaciones de movimiento. Discretizamos las ecuaciones en una superficie de malla triangular no múltiple y la acoplamos a un solucionador de burbujas existente. Al hacerlo, también introducimos un solucionador de fluidos incompresible para películas 2.5D y un nuevo algoritmo de advección para campos convecting a través de uniones superficiales no múltiples.

Estas simulaciones mejoran los solucionadores de burbujas de última generación con efectos adicionales causados por la convección, ondulación, drenaje y evaporación de la delgada película.

Si quieres saber más sobre el tema, puedes visitar la página del proyecto, donde puedes también ver un pdf con la investigación completa.

-- IMÁGENES ADJUNTAS --

|Agradecer cuando alguien te ayuda es de ser agradecido|

Una de las charlas en este Siggraph ha sido el Covid, sin duda es un tema del que se tenía que hablar, ya que ha dado muchos dolores de cabeza a las empresas y empleados, trastocando fechas de entrega y viéndose obligados a cambiar su forma de trabajo.

Uno de los grandes riesgos de esta forma de trabajo, es la seguridad de los datos, algo donde todavía se tiene que trabajar mucho para lograr un equilibrio coherente. No es fácil mantener los datos confidenciales cuando los artistas trabajan desde casa. La mayoría de ellos firman NDAs, pero el miedo a las filtraciones sigue presente. ¿Cómo podemos evitar que una persona que vive bajo el mismo techo que el artista coja o capture una fotografía de la última de Marvel o de Disney y la publique en las redes sociales?

Ninguno de los ponentes ha querido responder a esta pregunta, salvaguardar los datos, este ahora es el caballo de batalla para todas esas compañías, y parece que nadie sabe aporta una solución infalible.

En fin, esto es algo que si bien nos puede parecer transitorio, igual no lo es tanto, ya sea por Covid o por otros motivos de fuerza mayor, así que mejor que las empresas tengan previstos estos imprevistos.

Esta charla fue una oportunidad para aprender más sobre los enfoques de estudio de la pandemia. Un tema que, por supuesto, seguiremos en los próximos meses.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Otro proyecto que se desvela el en el evento, un rigging automatizado que está en desarrollo avanzado, el proyecto se llama RigNet.

Zhan Xu, Yang Zhou, Evangelos Kalogerakis (Universidad de Massachusetts Amherst), Chris Landreth, Karan Singh (Universidad de Toronto) revelan su proyecto de investigación, un método que genera personajes listos para usar. RigNet coge un modelo 3D y crea el solo el esqueleto necesario para generar cualquier movimiento, el sistema también puede calcular los pesos a partir del esqueleto.

El método se limita a los modelos articulados (por ejemplo, un perro y no un pulpo), y actúa directamente desde la malla, sin presuponer su estructura. Todo utiliza redes neuronales, y RigNet ha sido entrenado con una vasta colección de modelos ya amañados (mallas con esqueletos, pesos de piel).

Si este tipo de enfoque automático no es nada nuevo, el equipo argumenta que logra mejores resultados que el estado de la técnica al comparar métodos automáticos con plataformas creadas por humanos. Además, los equipos generados se pueden utilizar en varios niveles de detalle.

Aquí hay una presentación en video de la técnica. Ten en cuenta que la página RigNet, además de la publicación completa, ofrece código fuente y los datos utilizados para controlar el sistema.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Jugando con la simulación física en la cuarta dimensión es una sorprendente experiencia creada por Marc ten Bosch, donde nos invita a descubrir las alegrías de la simulación física con cuatro o más dimensiones físicas.

Marc adaptó su trabajo en una aplicación llamada 4D Toys, para ser descubierto en Steam (en VR o ratón y teclado) y la App Store de Apple. El resultado también se puede disfrutar a continuación en vídeo, un extraño universo en el que, en tiempo real, podremos manipular objetos con cuatro dimensiones físicas en lugar de tres. La cuarta dimensión obviamente no se puede representar visualmente, y permanece invisible. Como resultado, los objetos parecen desaparecer, emergen de la nada y se transforman a medida que se mueven en esta dimensión.

Para entender mejor el concepto, vamos a eliminar una dimensión, un equivalente de esta herramienta 2D podría ser proponer interactuar con objetos simulados en un espacio 3D, pero mostrando solo un segmento de ese espacio en la pantalla, un espacio visual 2D, por lo tanto. Por lo tanto, cuando una esfera cruza el plano podría, ser vista como un punto, un círculo y desaparecer. Del mismo modo, un cubo tomaría formas extrañas. Mejor aún, las colisiones podrían ocurrir en el espacio 3D y fuera del área visible, creando efectos sorprendentes.

El vídeo da una idea de este mundo simulado en 3D y se muestra en 2D desde aproximadamente 1 minuto 18 segundos.

La publicación técnica de Marc ten Bosch es generalista, si la demostración de 4D Toys está limitada a cuatro dimensiones, la formulación que da permite extender la simulación en cuerpos rígidos a un espacio que puede tener un gran número de dimensiones.

Si te interesa el tema, puedes ver más su web.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Cómo encuentro trabajo en la era de COVID, sin duda un tema muy interesante que se ha puesto de manifiesto en las charlas del Siggraph, charla que puso de relieve las últimas expectativas y desafíos para los reclutadores en la búsqueda de nuevos talentos. Tres oradores, Pamela Thompson, Susan Thurmond O'Neal y David Bromstein compartieron sus puntos de vista y consejos para establecer redes exitosas.

Cabe señalar que la información aquí dada es obviamente evaluada en función del contexto geográfico, la escala de la pandemia no es la misma en todos los países del mundo, y que las respuestas de los estudios y/o especialistas que se dedican a reclutar personal serán, por lo tanto, diferentes.

Las redes sociales y los foros dedicados al diseño gráfico son los principales vectores de investigación. Internet se han convertido en una herramienta por derecho propio y han asumido un papel aún más importante desde el comienzo de la crisis COVID-19, en parte debido al creciente número de usuarios de Internet conectados.

Sin embargo, las partes interesadas dijeron que, si bien las redes sociales y los foros deberían ser herramientas de búsqueda, sigue siendo muy recomendable dirigirse directamente al sitio web de la empresa. Numerosos casos de phishing por correo electrónico y anuncios falsos se han registrado en los últimos meses con el fin de recopilar información personal.

Demoreel, concéntrate en lo esencial. la demostración que te da a conocer debe destacar lo que es más importante para ti y aquello de lo que estás más orgulloso. La mayoría de los reclutadores o productores tendrán una opinión formada tras ver 30 segundos de tu reel, no hace falta más.

No muestres nunca imágenes de trabajos protegidos por derechos de autor, ninguna empresa confiará en el artista que para conseguir trabajo lleva muestras protegidas de lo que ha realizado en otra empresa.

Para crear tu demoreel también es bueno inspirarse en el trabajo de otros artistas sin apropiarse de su trabajo. Esta advertencia es, por desgracia, un recordatorio de que muchos candidatos se llevan el crédito por planes o personajes sin haber contribuido a ellos.

Las dificultades asociadas con la falta de filmación continúan, una de las principales preocupaciones desde el comienzo de esta pandemia ha sido el volumen de puestos de trabajo disponibles, de hecho, ya no es posible rodar películas o series en ciertas áreas geográficas, la mayoría de las personas que trabajan en un conjunto han experimentado una desaceleración significativa en su trabajo, los equipos que terminaron las películas antes de la pandemia están ahora de permiso, sin compensación económica de la compañía o el estado, pero han podido mantener su seguridad social. Otros tienen semanas más cortas, con un salario más bajo, o desafortunadamente se han hecho redundantes.

La competencia será feroz en Los Angeles tan pronto como regresen nuevos proyectos. Los artistas en diseño y/o animación de movimiento, parecen ser los únicos que pueden recuperarse y encontrar trabajo.

Las restricciones sanitarias han aumentado los costes de producción y, como resultado, el presupuesto final dedicado al proyecto se ha visto menguado. También hay una oleada de lanzamientos de películas directamente en plataformas de streaming.

El trabajo resultante se enfrentará a una competencia feroz entre los estudios VFX, lo que resulta en presupuestos más bajos, mientras que los costes siguen siendo los mismos. El mercado laboral corre un alto riesgo de verse inundado de artistas y especialistas con talento que compiten entre sí. Sin embargo, los artistas con una buena red y buenas recomendaciones serán capaces de llamar la atención de los estudios.

Por el lado del reclutamiento, surgen dos desafíos diferentes dependiendo de la posición de los reclutadores. Para trabajadores independientes el desafío es tratar de posicionarse como un recurso y su capacidad para proporcionar un talento desconocido para la empresa que también resulta ser la mejor.

Para los reclutadores que trabajan dentro de los estudios su desafío será encontrar artistas que acepten no trabajar desde casa, especialmente para trabajos con un NDA muy estricto. También será difícil cumplir con el gran número de candidatos para todos los puestos. Desafortunadamente, los reclutadores no podrán responder a las muchas aplicaciones.

¿Autónomos, los grandes ganadores?

La responsabilidad de las empresas de alojar a sus empleados en las instalaciones es importante hasta que la situación se considere bajo control. Parece que muchas pequeñas empresas con sede en Los Angeles se están dando cuenta de que trabajar remotamente les aporta una gran ventaja. En promedio, un empleado pasa dos horas en transporte, ahora tiene más tiempo para dedicarse a su familia y sus pasatiempos. Además, se reevaluarán los gastos generales (espacio, mobiliario de oficina, etc.) y se espera un cambio en los próximos meses. Por otro lado, otros estudios están deseando reanudar las operaciones normales y especialmente aquellos con proyectos confidenciales.

Esta experiencia de trabajo remoto ha sido capaz de mostrar a los empleadores lo que muchos ya sabíamos, no es el tiempo que pasas en el estudio lo que cuenta, sino más bien el logro de las tareas que se han asignado a los artistas.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Como parte del evento, un grupo de universitarios han presentado un proyecto donde explican cómo conseguir nieve y copos de nieve que interactúe de forma realista en las escenas, puedes leer más sobre el tema en https://foro3d.com/f42/simular-copos...na-142444.html.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Un proyecto artístico entre ecología y tecnología, presentado durante el evento, la galería de arte es una oportunidad para descubrir proyectos de arte basados en la tecnología. Neil Mendoza forma parte de la selección 2020 con dispositivos disruptivos, un tríptico que cuestiona nuestro impacto en la naturaleza y los animales.

En las diversas obras que componen este tríptico, un sistema mecánico permite interactuar con animales virtuales, manos que acarician o ahuyenten a un perro, un puño que molesta a los pollos mientras que otra mano a veces los libera para poner huevos, y finalmente las manos que vienen a liberar residuos en el estanque donde nada un pato.

Neil Mendoza explica que su objetivo es enfatizar cómo tratamos la naturaleza como si fuera un recurso infinito, con ecosistemas irreversiblemente perturbados. Los impactos a menudo amplificados por la tecnología. Los trípticos invitan a las personas que interactúan con ellos a reflexionar sobre su impacto en el medio ambiente a través de escenas surrealistas.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Otra gran aportación al este famoso festival, esta vez por parte de Marco Tempest. Director en Mit Media Lab, consultor creativo para nasa Jet Propulsion Laboratory, consultor en realidad extendida para Accenture, también es el fundador y director ejecutivo de MagicLab en Nueva York. Esta última entidad tiene como objetivo acercar la tecnología, a la ilusión y el arte.

Marco Tempest se especializa en inmersión y nuevas tecnologías, está interesado en la realización de nuevos conceptos. Esta aportación es una oportunidad para adentrarse en su visión de la realidad mixta, la narración, la captura de movimiento o la robótica, lo que nos lleva en todo caso a su visión de lo que nos espera en pocos años.

Dejo un enlace a la página de MagicLab porque me parece interesante.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Y concluye una nueva edición del Siggraph, 400.000 transmisiones en todo el mundo, los videos grabados que se exponen al público permanecerán activos has el 11 de septiembre.

El evento virtual fue sede de las últimas innovaciones en arte, ciencia y tecnología de más de 1600 colaboradores en 700 presentaciones durante su lanzamiento. Acogió a audiencias internacionales de 95 países.

La representación de seis de los siete continentes incluyó participantes de los Estados Unidos, Canadá, Japón, Nueva Zelanda, Zimbabue, Francia, Brasil, Israel, China y más.

La exposición de este año albergó a más de 80 empresas distintas, mostrando lo último en hardware de gráficos por ordenador, y software durante demostraciones virtuales personalizadas y más de 70 sesiones seleccionadas.

Lo más destacado de la conferencia incluyó una conferencia magistral del ejecutivo de MagicLab de Nueva York y el ilusionista cibernético, Marco Tempest, la presentación de 163 artículos de investigación y 69 carteles, tres cortometrajes animados de estreno mundial en el Computer Animation Festival Electronic Theater, el lanzamiento mundial de The Last Light de Magic Leap, una selección de VR Theater, y la presentación del primer proyecto AR de Felix & Paul Studios, una colaboración con The Jim Hensen Company, una cumbre de diversidad e inclusión de dos días, sesiones de producción y charlas centradas no sólo en el cine y los juegos, sino también en la televisión y la publicidad de prestigio, dos paneles retrospectivos celebraron a los pioneros de PDI (Pacific Data Images) y el NYIT Computer Graphics Lab, respectivamente y, el primero en emitirse en tiempo real a todo el mundo.

|Agradecer cuando alguien te ayuda es de ser agradecido|

El juego con varios años de retraso desde su anuncio ha dado noticias en el SIGGRAPH de este año, se trata de un juego muy elaborado, con mucho trabajo, ya que anunciaron que los personajes estarían animados sin utilizar captura de movimiento, esperando mostrar un gran realismo, y por si esto fuera poco, la sincronización labial sería en varios idiomas, lo cual multiplica el trabajo, el juego en cuestión es Cyberpunk 2077, más información en el hilo Cyberpunk 2077 desventuras y puesta en escena.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Otro producto destacado que se presentará en el evento es Stormscapes, un simulador de nubes que responden de forma interactiva con el entorno que le rodea, lo cual significa que reconocerá si hace viento y a qué velocidad, hacia donde sopla y a qué velocidad debe moverse la nube en el cielo. Todo esto responde a un completo estudio que han realizado y del que puedes leer más en el hilo de Stormscapes simula nubes con interacción dinámica.

-- IMÁGENES ADJUNTAS --

|Agradecer cuando alguien te ayuda es de ser agradecido|

Comunicado de prensa para la edición 2021 del Siggraph. Dada la continua incertidumbre en torno al futuro de Covid-19 y las restricciones de viaje en todo el mundo, Siggraph 2021 apuesta por la salud y la seguridad de la comunidad global de artistas y desde este momento anuncia que ya está planeando el evento solo de forma virtual.

La conferencia, originalmente programada para de agosto en el Centro de Convenciones de Los Angeles, se basará en el liderazgo del exitoso evento virtual Siggraph 2020.

Esperamos seguir honrando el legado de la industria de gráficos por computadora y técnicas interactivas y compartiendo las últimas innovaciones de nuestra talentosa comunidad.

Próximamente se darán las fechas actualizadas para la conferencia del próximo verano. Por favor, vuelve aquí para futuras actualizaciones y anuncios sobre Siggraph 2021.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Siggraph 2020 ha finalizado este años, aunque el registro sigue abierto con todo el contenido disponible hasta marzo de 2021, destacan 400 charlas y presentaciones sobre las últimas tecnologías en gráficos por ordenador, efectos visuales, realidad virtual, realidad aumentada y técnicas interactivas.

Los días del evento han pasado en un instante y no puedo creer que hayamos llegado al final de Siggraph, comentó el presidente de la conferencia. Han sido diez días realmente sorprendentes e inspiradores con un conjunto diverso de sesiones pregrabadas, así como sesiones en vivo y de estreno.

He aprendido mucho de las sesiones perspicaces e informativas impartidas por nuestros increíbles oradores de todo el mundo, y estoy seguro de que el evento virtual de este año fue otra conferencia inspiradora en la historia de Siggraph.

Para mí, la mejor parte de Siggraph es poder conectar y reunir a amigos. tanto antiguos como nuevos, en la industria, en un solo espacio, agregó Choo.

Aunque echamos de menos los eventos físicos en persona, me alegro de que mi equipo y yo hayamos logrado realizar una transición exitosa y reunir a todos en un entorno virtual a pesar de los muchos desafíos que se produjeron debido a la pandemia.

El evento virtual contó con más de 400 charlas y presentaciones sobre las últimas tecnologías en gráficos computar informáticos, efectos visuales, realidad virtual, realidad aumentada y técnicas interactivas.

Para acceder al contenido debes registrarte aquí.

La edición del próximo año se celebrará una vez más en el icónico Foro Internacional de Tokio en Tokio, Japón, del 14 al 17 de diciembre de 2021.

Dejo un video con la muestra de algunos de los trabajos presentados en el evento.

|Agradecer cuando alguien te ayuda es de ser agradecido|

SIGGRAPH 2021 simulando incendios realistas. Simulación a escala de incendios forestales, un trabajo destinado a simular un incendio a escala forestal y realista.

Se trata de simular el fuego, no las llamas, evidentemente estas están asociadas al fuego, pero no es el caso de estudio que se presenta en este evento.

En concreto, los investigadores proponen una formulación matemática del proceso de combustión que tenga en cuenta las plantas en detalle, las transferencias de calor, el hecho de que la carbonización crea una capa aislante, pérdida de masa, viento, etc.

Por lo tanto, la simulación es avanzada, como muestran los resultados, se tienen en cuenta factores como la pendiente del terreno, la densidad de los árboles o la lluvia.

Mejor aún, el efecto de los cortafuegos o líquidos retardantes está integrado en el modelo, lo que puede permitirnos visualizar el efecto de varias acciones contra incendios.

Efecto de la pendiente en la propagación del fuego

Implementado con un marco C-/CUDA, renderizado con una técnica de fundición de rayos, el método propuesto es lo suficientemente rápido como para una simulación interactiva en una estación de trabajo equipada con una tarjeta Geforce RTX reciente. Incluyendo escenarios bastante grandes, como una porción del Parque Nacional Yosemite con 68.000 árboles virtuales.

Propagar el fuego de un árbol a otro

Las aplicaciones de un proyecto de este tipo son variadas, y uno imagina que podría encontrar aplicaciones tanto en el entretenimiento simulando la progresión de un incendio para una película, o reconstruyendo un fuego real para un documental. Pero además de esas funciones, podría llegar a ser un software indispensable para la prevención de incendios.

Simulación de un incendio en Yosemite

Sin embargo, hay limitaciones, el modelo no tiene en cuenta el efecto del viento en la geometría de los árboles, el fuego está influenciado por el viento, pero los árboles son estáticos. Gestionar el efecto de la hierba, las hojas muertas y otros arbustos también sería un paso adicional en términos de realismo, pero requeriría muchos más cálculos.

Los investigadores también citan la resina de los árboles, el transporte aéreo de las chispas que se producen en un incendio, tener en cuenta los rayos, los incendios crean nubes que pueden desencadenar una tormenta cuyo rayo creará otras salidas de fuego, como pistas posteriores.

Por lo tanto, en los próximos años se podrán llevar a cabo más investigaciones para mejorar el sistema propuesto.

Para quien quiera estudiar más esta investigación, dejo aquí el enlace a la página oficial, y un PDF adjunto con cantidad de detalles importantes.

Aquí está la presentación del proyecto en video, seguido de detalles sobre el enfoque.

-- IMÁGENES ADJUNTAS --

|Agradecer cuando alguien te ayuda es de ser agradecido|

Simulación de incendios forestales realistas en 3D. El tema sigue avanzando y eso es buena noticia, muchos de los proyectos que se presentan al Siggraph acaban en nada por falta de recursos.

El nuevo enfoque recrea el proceso de combustión de una manera realista. El objetivo principal del equipo era capturar de manera realista el proceso de combustión de árboles individuales y la propagación resultante de incendios a escala de bosques.

Para ello se basan en un enfoque de modelado de vanguardia para ecosistemas a gran escala que nos permite representar cada planta como un modelo geométrico 3D detallado.

Ahora introducen una nueva formulación matemática para el proceso de combustión de las plantas, también teniendo en cuenta efectos como la transferencia de calor, el aislamiento de carbón y la pérdida de masa, así como para la propagación del fuego a través de todo el ecosistema.

La transferencia de calor o el calor acumulado en la zona influye en gran manera a que el incendio se propague con mayor velocidad.

El equipo cree que la fuerza principal de este modelo es la capacidad de simular la interacción de las variaciones geométricas de las estructuras de ramificación y la dinámica del fuego y la combustión de madera. También señalan que el modelo se ejecuta a velocidades interactivas que permiten a los usuarios experimentar con diferentes escenarios.

Recordar que este proyecto está basado en datos reales, en la física, así que puede ser muy buena cosa. Todavía le falta mucho, esperemos que sigan adelante con la misma fuerza.

|Agradecer cuando alguien te ayuda es de ser agradecido|

Con una amplia gama de medidas de seguridad e higiene en el lugar, el evento dará la bienvenida a los asistentes en persona en el Foro Internacional de Tokio desde el 14 hasta el 17 de diciembre. Los asistentes internacionales de todo el mundo podrán unirse virtualmente.

En respuesta a la nueva variante de Omicron, el gobierno japonés ha anunciado este 29 de noviembre que el país prohibirá la entrada a todos los viajeros internacionales durante un mes. El organizador de la Conferencia híbrida SIGGRAPH Asia 2021 ya se estaba preparando para que el evento continuara con muy pocos oradores internacionales y asistentes físicamente presentes debido a los estrictos procesos establecidos para obtener visas de viaje a Japón. Por lo tanto, no hay grandes cambios debido al nuevo cierre de las fronteras de Japón.

Aunque actualmente nos enfrentamos al desafío de la propagación de una nueva variante de Covid-19, hemos decidido celebrar SIGGRAPH Asia 2021 según lo programado mientras hacemos los máximos esfuerzos para garantizar la seguridad de todos los visitantes, presentadores y personal de administración. Este es el primer evento híbrido en el que puedes comunicarte físicamente y experimentar las presentaciones de los principales profesionales del mundo en gráficos por ordenador y tecnologías interactivas, así como investigadores académicos y profesionales.

SIGGRAPH Asia 2021 se ajustará a las medidas de enfermedades infecciosas

La exposición y conferencia SIGGRAPH Asia 2021 se llevará a cabo de conformidad con las regulaciones COVID-19 del gobierno; las autoridades locales y la industria de exposiciones para garantizar la seguridad y el bienestar de todos los asistentes.

SIGGRAPH Asia 2021 tendrá en cuenta la política básica sobre contramedidas para enfermedades infecciosas causadas por nuevos coronavirus. Actualizada a partir del día 19 de noviembre de 2021. El Foro Internacional de Tokio también se ha asociado con el Gobierno Metropolitano de Tokio y organizaciones relacionadas para prevenir aún más la propagación de Covid-19 en el lugar.

Además, en SIGGRAPH Asia 2021 se implementarán medidas de seguridad e higiene en el lugar del evento. Como control de temperatura, máscaras obligatorias que deben usarse en todo momento, desinfectantes de manos que se colocarán en las entradas, distanciamiento social y otras medidas.

SIGGRAPH Asia 2021 en el Foro Internacional de Tokio

SIGGRAPH Asia 2021 tendrá lugar en el Foro Internacional de Tokio, Japón y online desde el día 14 hasta el día 17 de diciembre. La conferencia de cuatro días incluye una amplia gama de programas con jurado. Como la Galería de Arte, Pájaros del mismo plumaje, Festival de la animación por ordenador, Cursos, Tecnologías emergentes, Comunicaciones técnicas, Realidad extendida.

Los programas seleccionados incluyen Demoscene, sesiones destacadas, juegos y keynotes. Una exposición de tres días que se llevará a cabo desde el día 15 hasta el día 17 de diciembre proporcionará una plataforma de negocios para que los actores de la industria comercial expongan sus productos y servicios innovadores a los profesionales y entusiastas de los gráficos por ordenador y las técnicas interactivas de Asia y más allá.

Para obtener más información sobre la programación de esta edición híbrida, visita el sitio.

Fuente: SIGGRAPH Asia 2021

-- IMÁGENES ADJUNTAS --

|Agradecer cuando alguien te ayuda es de ser agradecido|

Convocatoria de presentaciones SIGGRAPH Asia 2022. Regresa el festival de animación por ordenador SIGGRAPH. Ya aceptan trabajos para participar en el evento en múltiples categorías, incluidos cortometrajes, visualizaciones, secuencias de VFX, cinemáticas de juegos y piezas en tiempo real.

La fecha límite para participar es el 31 de julio de 2022.El SIGGRAPH Asia 2022 Computer Animation Festival (SACAF 2022) ya está abierto para inscripciones. El festival invita a creadores de todo el mundo a enviar sus proyectos y ayudar a mostrar la animaciones por ordenador más innovadoras y emocionantes del mundo.

El próximo diciembre, SACAF 2022 se reunirá en Daegu, Corea del Sur, para celebrar el mundo vibrante, diverso e inspirador de la animación por ordenador. Desde cortometrajes hasta visualizaciones científicas y deepfakes mejorados con IA (inteligencia artificial). El festival de este año promete su programa más amplio y atractivo hasta la fecha.

Convocatoria de presentaciones SIGGRAPH Asia 2022

Convocatoria de presentaciones SIGGRAPH con los mejores trabajos

Un jurado internacional de los mejores expertos en animación por ordenador juzgará los mejores trabajos presentados en cada categoría. De ese grupo de selecciones principales, se entregarán tres prestigiosos premios 2022.

Mejor Proyecto Estudiantil, Especial del Jurado y Best in Show. Además, los jueces seleccionarán entre 30 y 40 (o más) obras, lo mejor de lo mejor de todo el grupo de presentaciones, para seleccionarlas en las dos estrellas del festival. Las siempre espectaculares proyecciones de Teatro Electrónico y Teatro de Animación.

Como cada año, el Teatro Electrónico y el Teatro de Animación no dejan de deslumbrar y deleitar al público de la conferencia. Un público ansioso por sentarse y disfrutar de una muestra entretenida y estimulante de la mejor animación generada por ordenador del mundo.

Si está animado y se usó un ordenador en alguna parte de tu producción, SACAF 2022 quiere verlo. Únete a las festividades y ayuda al festival a honrar lo mejor de la animación CG. Envía tus últimos proyectos en cualquiera de las siguientes categorías.

Categorías del evento SIGGRAPH Asia 2022

Cortometrajes animados por ordenador: Incluye animación de personajes, trabajos narrativos, trabajos experimentales, secuencias de apertura; cinemáticas de juegos, selecciones y/o montajes de series de televisión animadas, formatos de nuevos medios.

Largometrajes de Animación: Selecciones y/o montajes de animación por ordenador creados para largometrajes de animación.

Videos musicales: Trabajos independientes y/o comisionados que usan cualquier combinación de animación por computadora; efectos digitales y acción en vivo para ilustrar, mejorar y/o complementar una creación musical.

Comerciales de TV y Web: Anuncios creados total o parcialmente con animación por computadora y/o efectos digitales. Esta categoría también incluye anuncios promocionales, streaming y anuncios de servicio público.

Visualizaciones y simulaciones: Animaciones por ordenador creadas para explicar, analizar o visualizar información para aplicaciones que incluyen; investigación científica, arquitectura, ingeniería, simulaciones de sistemas, educación y proyectos documentales.

Efectos visuales para películas y programas de televisión: Selecciones y/o montajes de efectos visuales creados para películas de acción real y/o para programas de televisión.

Animación en tiempo real: Animaciones de juegos, web y móviles que se procesan en la misma cantidad de tiempo que lleva reproducirlas.

¡También se recomiendan demostraciones de tecnología en tiempo real! Las demostraciones de tecnología en tiempo real deben enviarse a Real-Time Live!

Otras categorías: Animaciones por ordenador que no encajan en ninguna de las categorías anteriores.

SIGGRAPH Asia 2022

Fecha límite de presentación SIGGRAPH Asia 2022

La fecha límite de envío es el 31 de julio de 2022. Visite la página web de SACAF 2022 para obtener más información. Incluido cómo enviar, las reglas y los requisitos de envío, y las preguntas frecuentes.

O puedes enviar tu trabajo directamente iniciando sesión en el Sistema de envío de SIGGRAPH Asia.

Manifiesto del sector 3D

La gente está de vuelta en los cines, los streamers están llenando sus plataformas con entretenimiento animado para todas las audiencias en todos los géneros. El metaverso está en boca de todos, y las empresas de tecnología, grandes y pequeñas; continúan expandiendo cómo los grandes datos pueden convertirse más fácil y rápidamente en útiles.

Cada día hay nuevas herramientas creativas y plataformas de colaboración, desde producción virtual y flujos de trabajo en tiempo real basados en motores de juegos hasta visualizaciones impulsadas por estaciones de trabajo virtuales de alto rendimiento basadas en la nube, se está produciendo más animación CG que nunca.

|Agradecer cuando alguien te ayuda es de ser agradecido|