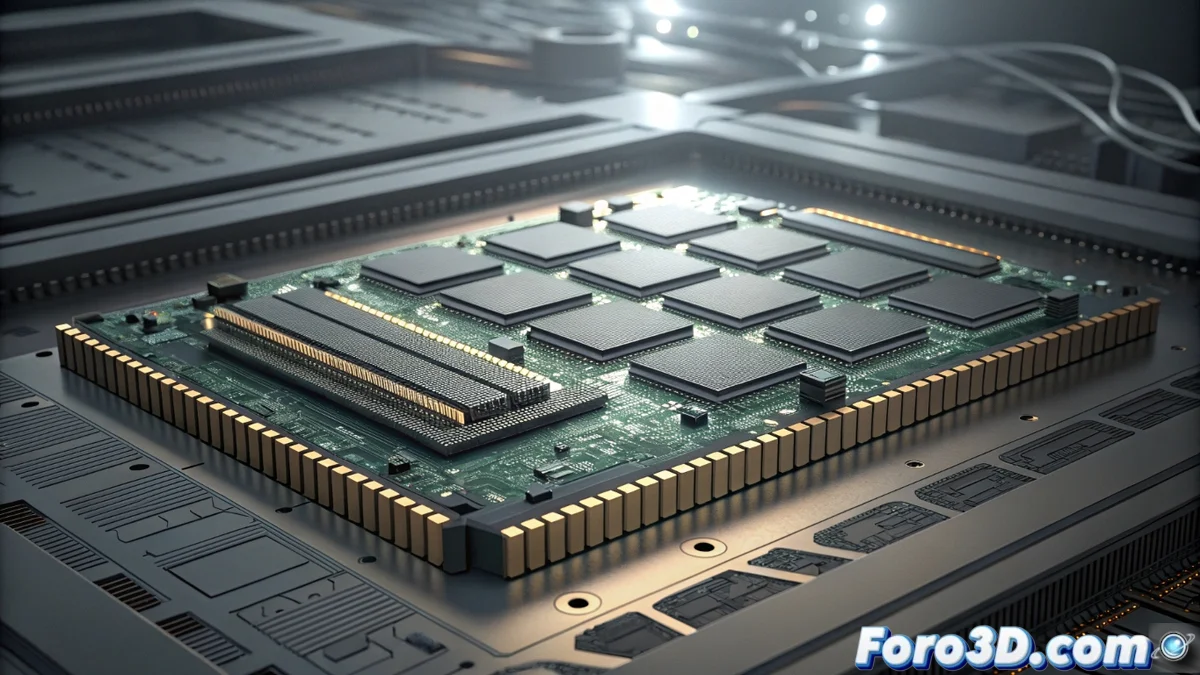

Micron presenta la HBM3 Gen2 per accelerare l'intelligenza artificiale

La corsa al processamento di dati massivi riceve una nuova spinta con l'annuncio di Micron sulla sua memoria HBM3 Gen2. Questa tecnologia rappresenta un significativo avanzamento nel campo dell'alta larghezza di banda, creata specificamente per alimentare la prossima generazione di GPU e acceleratori dedicati all'intelligenza artificiale. Il suo obiettivo è superare le attuali strozzature, permettendo un flusso di informazioni più rapido ed efficiente per carichi di lavoro estremi 🚀.

Specifiche e architettura migliorata

Le caratteristiche tecniche della HBM3 Gen2 stabiliscono nuovi parametri. Ogni stack di memoria è in grado di supportare velocità di trasferimento che raggiungono i 819 GB/s, mentre la densità per unità si eleva fino a 64 GB. Questo salto quantitativo è fondamentale per gestire gli enormi set di dati richiesti dall'apprendimento automatico e dal calcolo scientifico. L'architettura si basa su un apilamento 3D che non solo compatta la capacità, ma ottimizza anche il consumo energetico e migliora la dissipazione termica, fattori critici nei data center.

Avanzamenti chiave dell'architettura:- Interfaccia ad ultra alto rendimento con 819 GB/s per stack.

- Alta densità di 64 GB per dispositivo, facilitando configurazioni compatte.

- Tecnologia di apilamento 3D per maggiore efficienza energetica e termica.

L'integrazione della HBM3 Gen2 con chip all'avanguardia assicura che la larghezza di banda si allinei con le esigenze di velocità di clock più elevate in applicazioni critiche.

Impatto sull'hardware all'avanguardia

Nell'hardware avanzato, questa memoria trova la sua applicazione più diretta. Le GPU per l'addestramento di modelli neuronali e gli acceleratori IA saranno i principali beneficiari, poiché possono processare grandi volumi di informazioni senza interruzioni. Micron ha progettato questa soluzione per un'integrazione senza soluzione di continuità con i processori più potenti sul mercato, garantendo che le prestazioni del sistema siano limitate dalla potenza di calcolo e non dalla velocità della memoria. Rapporti dell'industria evidenziano il suo ruolo essenziale nello sviluppo di infrastrutture di calcolo ad alto rendimento (HPC).

Applicazioni principali:- Addestramento IA e modelli linguistici su larga scala (LLM).

- Calcolo ad alto rendimento (HPC) per simulazioni scientifiche.

- Analisi dei dati in tempo reale e carichi di lavoro intensivi.

Una corsa tecnologica senza fine

La presentazione della HBM3 Gen2 sottolinea la dinamica implacabile dell'innovazione. Sebbene stabilisca un nuovo punto di riferimento in velocità e capacità, la paradosso persiste: l'insaziabile domanda degli algoritmi IA potrebbe superare persino questi standard in un futuro prossimo. Questo ciclo riflette la natura della tecnologia, che avanza costantemente verso un orizzonte in movimento, spingendo l'industria a cercare soluzioni sempre più potenti ed efficienti. La scommessa di Micron consolida le basi per la prossima ondata di applicazioni di intelligenza artificiale che trasformeranno diversi settori 🤖.