I sistemi di IA nelle infrastrutture critiche richiedono certificazione

Implementare intelligenza artificiale in ambiti dove un errore può costare vite umane o provocare catastrofi materiali non è un compito banale. 🛡️ Gli organismi regolatori esigono che questi sistemi, come quelli che modellano strutture civili o pianificano interventi chirurgici complessi, dimostrino un livello eccezionale di affidabilità prima di poter essere utilizzati. Questo scrutinio formale, noto come certificazione, è la barriera che separa un prototipo da uno strumento operativo in settori ad alto rischio.

Il processo per verificare che un sistema sia robusto e sicuro

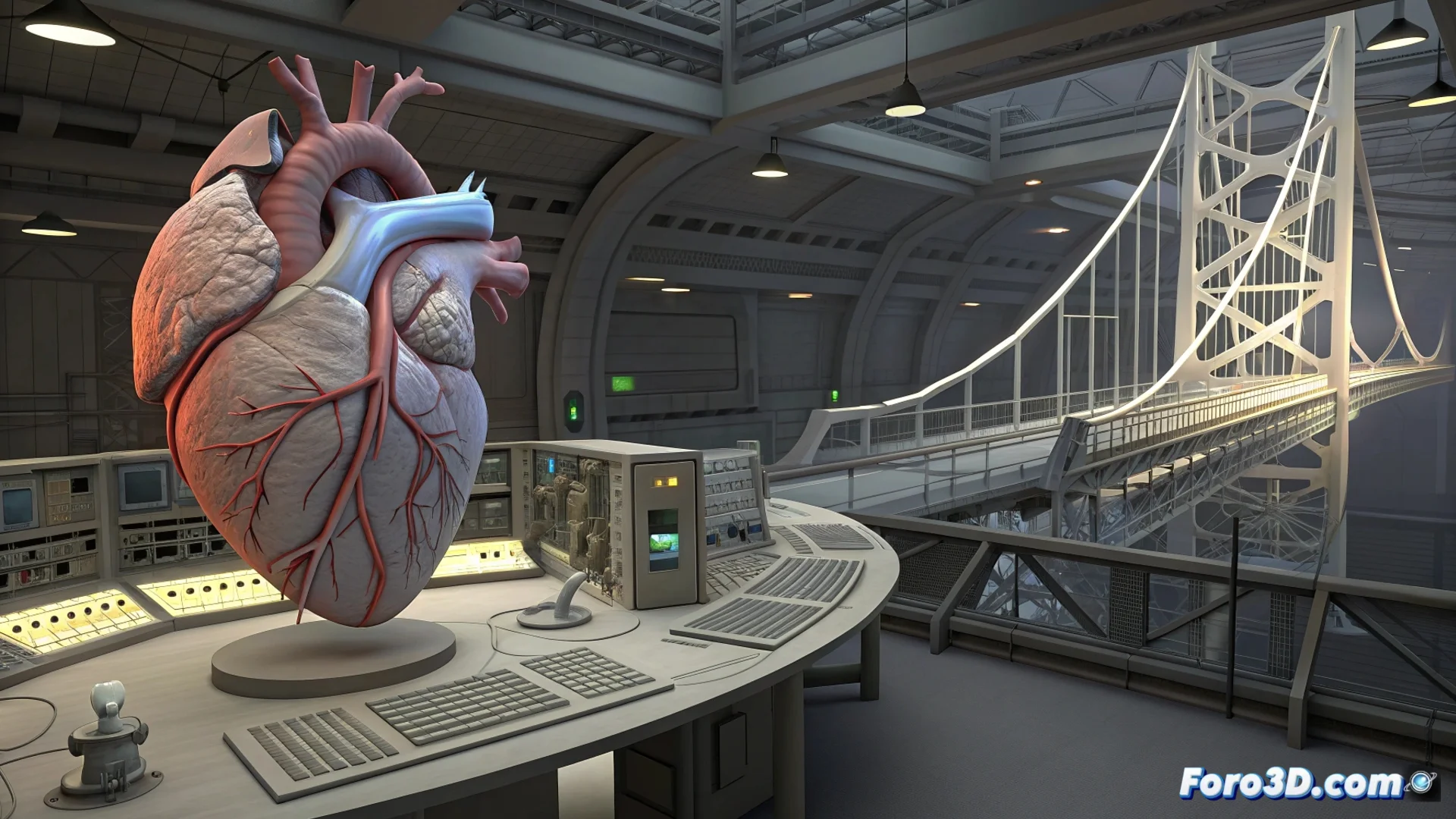

Il cuore della certificazione risiede nel sottoporre l'algoritmo di IA a un insieme di test esaustivi e spesso avversari. I valutatori non solo verificano il suo funzionamento in condizioni normali, ma cercano attivamente di farlo fallire. Introducono dati corrotti, simulano cyberattacchi ed esplorano i limiti della sua logica per trovare punti deboli. Per un software che calcola tensioni in un edificio o il comportamento di un farmaco nel corpo, un risultato errato è inaccettabile. Per questo, i test replicano scenari estremi che potrebbero verificarsi nella vita reale, assicurando che il sistema si comporti in modo prevedibile e controllato sempre.

Aree chiave che vengono esaminate:- Resilienza a errori e attacchi: Come reagisce il sistema quando riceve informazioni errate o malevole.

- Spiegabilità delle decisioni: Capacità di comprendere e giustificare perché l'IA è arrivata a una conclusione specifica, cruciale per auditarne il lavoro.

- Rilevazione e correzione di bias: Analisi per identificare pregiudizi negli algoritmi che possano portare a risultati discriminatori o tecnicamente pericolosi.

La certificazione finale non è un semplice sigillo; è la conferma che il sistema soddisfa tutti i requisiti tecnici e legali per operare proteggendo persone e beni.

La normativa si adatta al ritmo dei progressi tecnologici

Ottenere la certificazione non è un evento unico, ma l'inizio di un impegno continuo. Gli standard e le regolamentazioni evolvono tanto rapidamente quanto la tecnologia dell'IA stessa. Questo obbliga gli sviluppatori a monitorare le prestazioni dei loro sistemi una volta distribuiti e a essere pronti ad applicare patch e aggiornamenti che correggano vulnerabilità o migliorino il funzionamento. Un pilastro fondamentale in questo processo è la tracciabilità assoluta: deve essere possibile tracciare e auditarne ogni passo logico e ogni decisione presa dall'IA, il che frequentemente richiede architetture software speciali