Micron stellt HBM3 Gen2 vor, um Künstliche Intelligenz zu beschleunigen

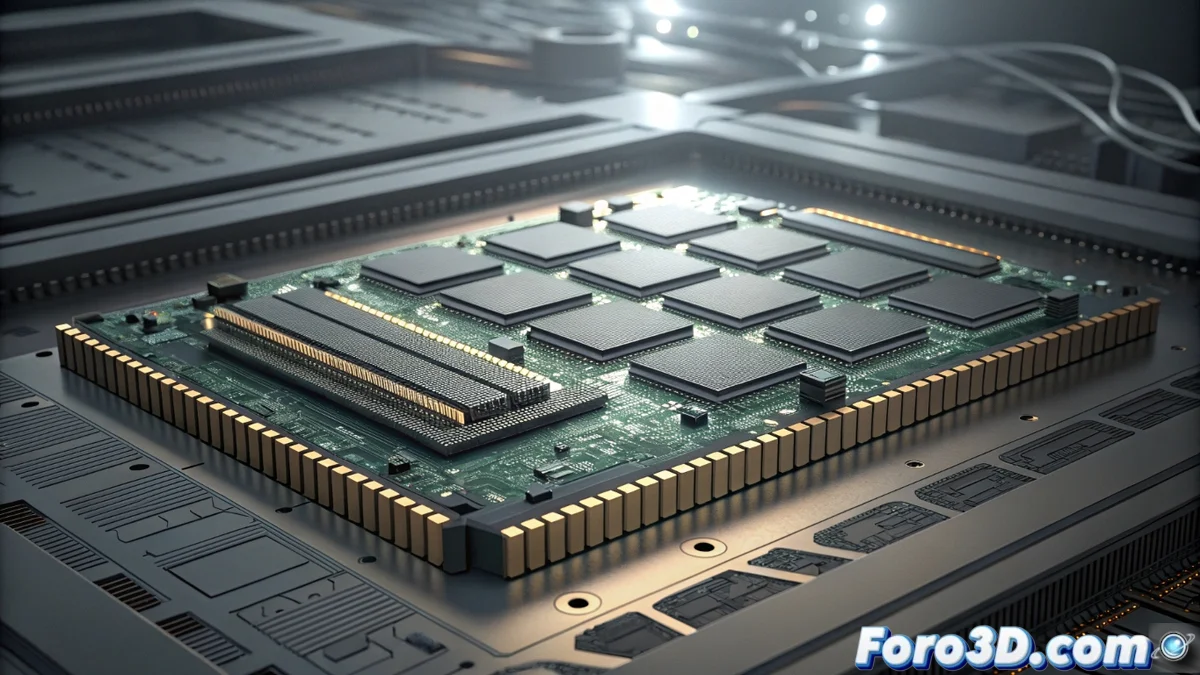

Der Wettlauf um die Verarbeitung massiver Datenmengen erhält einen neuen Schub durch die Ankündigung von Micron bezüglich ihrer Speichertechnologie HBM3 Gen2. Diese Technologie stellt einen signifikanten Fortschritt im Bereich des hohe Bandbreite dar, speziell entwickelt, um die nächste Generation von GPU und dedizierten Beschleunigern für Künstliche Intelligenz zu versorgen. Ihr Ziel ist es, die aktuellen Engpässe zu überwinden und einen schnelleren und effizienteren Datenfluss für extreme Workloads zu ermöglichen 🚀.

Spezifikationen und verbesserte Architektur

Die technischen Merkmale der HBM3 Gen2 setzen neue Maßstäbe. Jeder Stack der Speicher kann Übertragungsraten von bis zu 819 GB/s unterstützen, während die Dichte pro Einheit auf bis zu 64 GB steigt. Dieser quantitative Sprung ist entscheidend für die Bewältigung der enormen Datensätze, die für Maschinelles Lernen und wissenschaftliches Rechnen benötigt werden. Die Architektur basiert auf einem 3D-Stapeln, das nicht nur die Kapazität verdichtet, sondern auch den Energieverbrauch optimiert und die Wärmeableitung verbessert – kritische Faktoren in Rechenzentren.

Schlüsselverbesserungen der Architektur:- Schnittstelle mit ultra-hoher Leistung von 819 GB/s pro Stack.

- Hohe Dichte von 64 GB pro Gerät, die kompakte Konfigurationen ermöglicht.

- 3D-Stapeltechnologie für höhere Energie- und Wärmeeffizienz.

Die Integration von HBM3 Gen2 mit Spitzenchips stellt sicher, dass die Bandbreite mit den Anforderungen höherer Taktfrequenzen in kritischen Anwendungen übereinstimmt.

Auswirkungen auf Spitzenhardware

Im fortschrittlichen Hardware findet dieser Speicher seine direkteste Anwendung. GPU für das Training von Neuronenmodellen und KI-Beschleuniger werden die Hauptbegünstigten sein, da sie große Datenmengen ohne Unterbrechungen verarbeiten können. Micron hat diese Lösung für eine nahtlose Integration mit den leistungsstärksten Prozessoren auf dem Markt entwickelt und gewährleistet so, dass die Systemleistung durch die Rechenleistung und nicht durch die Speichergeschwindigkeit begrenzt wird. Branchenberichte heben ihre essenzielle Rolle bei der Entwicklung von Hochleistungsrecheninfrastrukturen (HPC) hervor.

Hauptanwendungen:- KI-Training und Modelle großer Sprachmodelle (LLMs).

- Hochleistungsrechnen (HPC) für wissenschaftliche Simulationen.

- Datenanalyse in Echtzeit und intensive Workloads.

Ein endloser Technologiewettlauf

Die Vorstellung der HBM3 Gen2 unterstreicht die unerbittliche Dynamik der Innovation. Obwohl sie einen neuen Maßstab in Geschwindigkeit und Kapazität setzt, bleibt das Paradoxon bestehen: Die unersättliche Nachfrage der KI-Algorithmen könnte diese Standards in naher Zukunft sogar übersteigen. Dieser Zyklus spiegelt die Natur der Technologie wider, die ständig auf einen beweglichen Horizont zustrebt und die Industrie antreibt, immer leistungsstärkere und effizientere Lösungen zu suchen. Der Einsatz von Micron legt die Grundlage für die nächste Welle von KI-Anwendungen, die verschiedene Sektoren transformieren werden 🤖.